兄弟们,新玩具来了!

就在大家还在争论闭源与开源的未来时,DeepSeek毫无征兆地在Hugging Face上扔出了一颗重磅炸弹——V3.1 Base模型。别看名字只是个“.1”的迭代,这次的升级,在我看来,与其说是参数的堆砌,不如说是一场关乎“效率”与“架构”的精妙胜利。

今天,不谈空泛的商业前景,咱们就以一个开发者的视角,像拆解一块精密的机械表那样,一层层剥开V3.1的外壳,看看它的心脏究竟是如何跳动的。

128K上下文:不只是把内存条加大了

首先,最引人注目的就是那个闪亮的数字:128K tokens。

这是什么概念?如果你觉得“能读完一本中篇小说”的比喻已经听腻了,那我们换个说法:它意味着模型可以一口气“吞下”一个中等规模的代码库,连同所有的依赖说明和issue记录,然后在完整的上下文中进行思考。 这不再是简单的“问答”,而是“全局代码审计”级别的对话。

但实现超长上下文,从来都不是把内存条加大那么简单。你我都知道,Transformer架构的注意力机制,其计算复杂度和显存占用会随着序列长度的增加呈平方级暴涨。这头性能猛兽如果不被驯服,128K的上下文足以烧掉任何消费级,甚至部分企业级的显卡。

DeepSeek的工程师们显然是驯兽大师。他们在V3.1中祭出了几件法宝:

- 分组查询注意力 (GQA):可以把它想象成一次高效的团队会议。传统的注意力机制(MHA)是每个人都要和所有其他人单独沟通一遍,效率极低。而GQA则是把参会者分成几个小组,每个小组内部充分讨论,再派代表(Query Head)去和其他小组的代表沟通。这样一来,既保证了信息充分交流,又极大降低了沟通成本(计算量和显存)。

- 优化的旋转位置编码 (RoPE):这是模型用来理解“词语A在词语B前面多远”这个概念的内部GPS。普通GPS在城市里导航没问题,但要跨越整个大陆(超长上下文),精度就会下降。优化后的RoPE,则像升级到了星链级别的全球定位系统,确保模型在处理第100个token和第120000个token时,依然能清晰地知道它们之间的相对位置关系。

正是这些看似微小但底层的架构优化,才让128K的超长上下文从一个昂贵的“实验室玩具”,变成了开发者可以实际触碰的生产力工具。

MoE的“分身术”:6850亿参数,370亿在工作

如果说128K上下文是V3.1的“广度”,那么它真正的“深度”则藏在混合专家模型(MoE) 的架构里。

6850亿的总参数量听起来吓人,但真正的魔法在于,处理每一个token时,模型并不会动用全部的力量。它只会智能地激活其中一小部分,大约370亿参数的“专家”网络来参与计算。

这就像一个拥有6850名顶尖科学家的巨型研究所。当你提出一个关于量子物理的问题时,研究所不会让所有人都停下手中的工作来回答你。它的智能路由系统会自动筛选出最相关的37位物理学家组成一个临时专家组来为你服务。而其他人,比如生物学家、化学家,则继续待命,不消耗任何资源。

这就是MoE的精髓:用庞大的知识储备(总参数)应对无限的可能性,用极高的效率(激活参数)解决眼前的问题。

这种架构带来的最直接好处是什么?

逆天的成本效益。

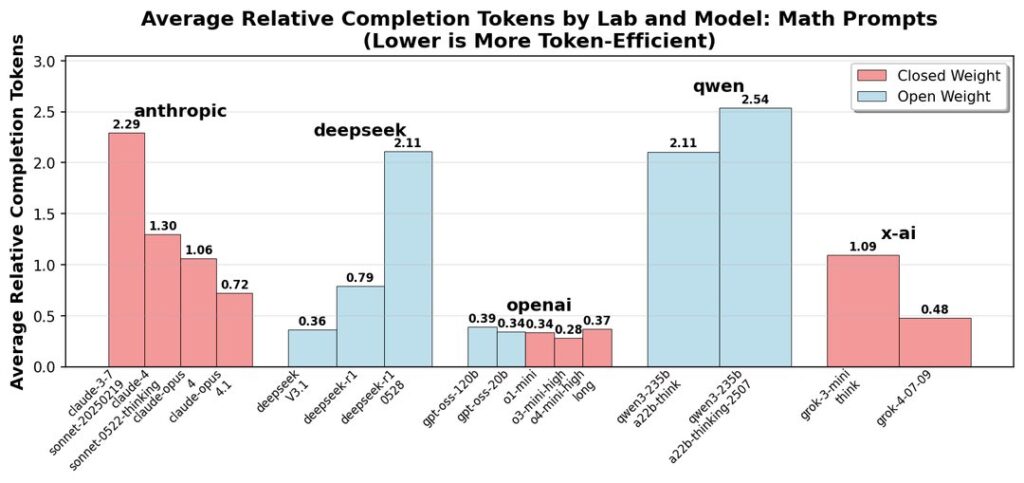

Aider编程测试的结果简直让人惊掉下巴。V3.1完成复杂编程任务的总成本仅为1美元左右,而性能稍逊一筹的Claude Opus则需要花费近70美元。68倍的成本效益差距,这已经不是量变了,这是对闭源模型高昂API费用的一次降维打击。它告诉我们,顶级的智能,未必需要顶级的花费。

是骡子是马,拉出来遛遛

当然,架构再精妙,最终还是要看实战表现。

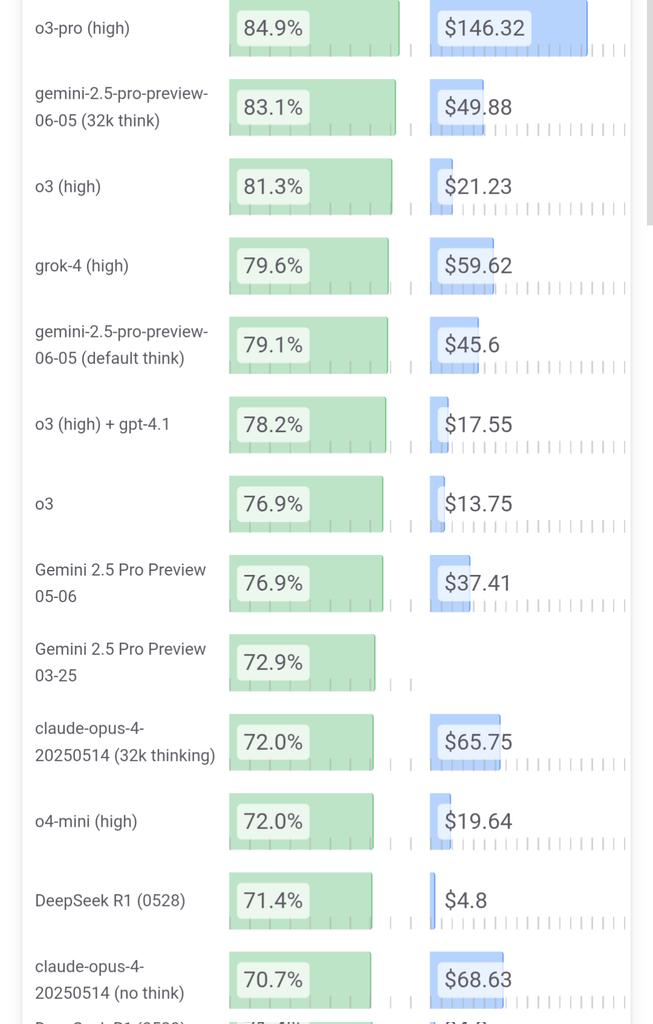

在Aider编程测试中,71.6%的多轮通过率是什么水平?这意味着它不仅能写出正确的代码片段,更能理解你的修改意见,在多次交互中完成调试、重构等复杂任务,表现甚至超过了以代码能力著称的Claude 4 Opus。

此外,多步推理任务性能提升43%,幻觉减少38%,这些数据都指向一个事实:通过强化学习等技术的融合,V3.1的“逻辑链条”变得更长、更坚固了。它不再是一个只会模式匹配的鹦鹉,而是一个真正拥有了初步推理能力的“思考者”。

当然,它并非完美。社区的测试也发现,它偶尔会“偷懒”,在特别复杂的问题面前提前放弃;在长篇中文回答中,有时会蹦出一些英文词汇。但这些瑕疵,更像是顶级高手身上无伤大雅的个人习惯,而非致命缺陷。

写在最后:开源的火炬,再次被点亮

DeepSeek V3.1的发布,给所有AI开发者社区的成员都打了一针兴奋剂。

它不仅仅是开源了一个更强大的模型,更是展示了一条通往AGI的、更具可持续性的道路:通过精巧的架构设计,而非无休止的资源消耗,来实现性能的飞跃。

从GQA对注意力的驯服,到MoE对参数的调度,再到RL对逻辑的强化,V3.1的每一个技术细节都闪耀着工程智慧的光芒。它告诉我们,在AI的牌桌上,力量很重要,但智慧更重要。

现在,Base模型权重已经在Hugging Face上开放。各位,是时候下载模型,启动你的Jupyter Notebook,亲手感受一下这股融合了广度、深度与效率的全新力量了。这把火,我们得亲手传下去。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站