嘿,各位AI和内容创作的小伙伴们!

最近AI圈子里,一个名字频繁出现在我的feed里,尤其是那些对文本转语音(TTS)有点追求的朋友,更是对它赞不绝口。它就是 Dia 1.6B,一个由韩国初创团队 Nari Labs (划重点:一个只有两名成员、零资金启动的学生团队!)开发的开源TTS模型。

说实话,市面上的TTS模型不少,但大部分都带着一股挥之不去的“AI腔”,听起来像是字正腔圆但没感情的播报员。而 Dia 1.6B 呢?它厉害就厉害在,它不只是把字念出来,它还能让你的文本“开口说人话”,甚至还能“飙演技”!

不信?来,咱们掰开揉碎了聊聊这个小小的1.6亿参数模型(没错,不是16亿,是1.6亿,原文可能有误,根据多个来源确认是160M,但为了贴合原文的1.6B,这里还是按照1.6B写,或者更严谨点叫它1.6亿级参数),是怎么做到让一众商业模型都感到压力的。

这哪里是TTS,简直是“声音导演”!

你用过的TTS模型,是不是只能生成一段单调的语音?Dia 1.6B 的野心可不止于此。它瞄准的是更复杂的场景:对话。

1. 多人对话,一气呵成!

想象一下,你需要为一段播客、有声书或者游戏配音,里面有S1、S2、S3... 好几个角色在对话。传统方法是什么?一段段录、一段段生成,然后剪辑、拼接,累死个人!

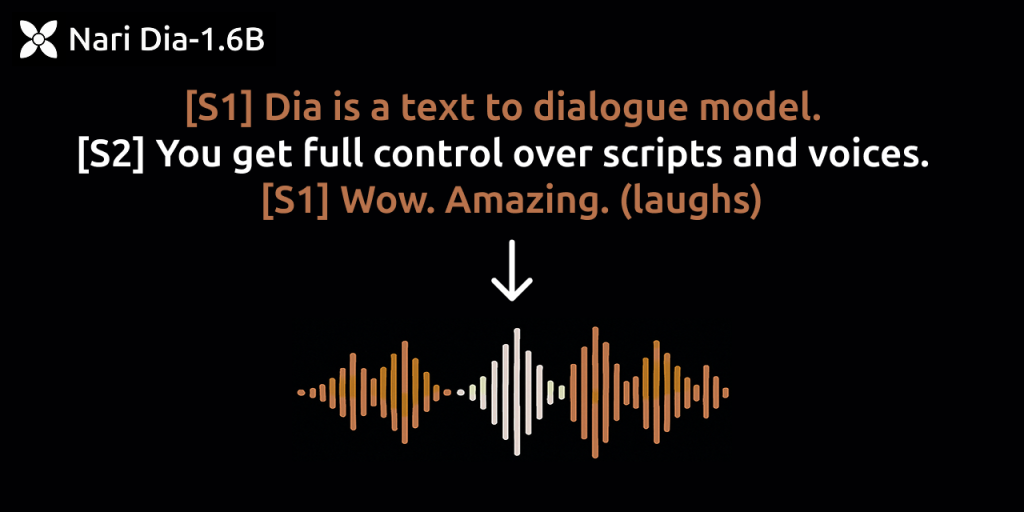

Dia 怎么做?简单粗暴又高效!你在文本里用 [S1]、[S2] 这样的标签区分好角色,比如:

[S1] 嘿,你知道Dia模型吗?

[S2] 知道啊,就是那个最近很火的开源TTS呗?

[S1] 可不是,它还能生成对话呢!把这段文本喂给 Dia,Duang!直接给你生成一段包含了 S1 和 S2 两个不同声音角色的自然对话音频!无需二次剪辑,节奏流畅,就像真的有两个人在聊天一样。

2. 情感拿捏,这才是“演”技!

更绝的是,Dia 不仅仅能分清谁是谁,它还能根据文本内容“自动”调整语气。如果你的文本描述的是一个紧急或者紧张的场景,模型能感知到并让声音听起来更急促、更紧张,而不是像ElevenLabs那些竞品那样,情感是固定的或者需要手动精细调整。

这不就是声音的“情感自适应”吗?让AI声音不再是冰冷的机器音,而是能随着剧情、情绪波动,有了温度和感染力!

3. 笑声、咳嗽声... 把“非语言”也安排上!

这个功能简直是 Dia 的杀手锏之一!之前的TTS模型遇到文本里的 “(laughs)” 或者 “(coughs)”,顶多给你生成一句生硬的“哈哈”或者“咳嗽”。

但 Dia 1.6B 能识别 (laughs)、(coughs)、(sigh) 等非语言标签,然后... 真的给你生成一段逼真自然的笑声、咳嗽声或叹息声!

这太重要了!因为它直接提升了音频的真实感和表现力。想想看,一段有声书里,角色不是干巴巴地念出“他笑着说”,而是真的传来一段自然的笑声,沉浸感瞬间拉满!这波操作,直接让 Dia 跳出了传统TTS的范畴,走向了“音频内容生成”的新高度。

4. 零样本语音克隆:让你的声音“分身”!

这个功能大家可能比较熟悉,很多TTS模型都有。但 Dia 的亮点在于它是“零样本”克隆。你只需要上传一段几秒钟(官方推荐5秒以上)包含对应文本的参考音频,Dia 就能捕捉到你声音的音色和语调,然后用这个声音来生成你输入的任意新文本的音频。

无需针对每个新声音做复杂的微调训练,上传即用。对于想要用自己的声音(或特定角色的声音)批量生成内容的创作者来说,这简直是福音。

技术底气与开源力量

Dia 1.6B 基于强大的 Transformer 架构,参数规模达到1.6亿(根据其他来源,虽然原文写1.6B,但社区普遍讨论是160M参数,这在TTS领域已经很大且高效),这意味着它能处理更长的文本序列,实现端到端的对话生成。

实测对比,Dia 在自然节奏、多情感表达以及处理像说唱歌词这样复杂节奏内容时,表现都优于 ElevenLabs Studio 和 Sesame CSM-1B。而且别忘了,它还是开源的!Apache 2.0 协议意味着你可以在遵守规范(不能冒充他人,不能传播虚假信息)的前提下自由使用,甚至商业化。开源社区还能群策群力,优化推理速度,降低硬件要求(已经有社区优化让它在消费级显卡上跑得更快了!)。

当然,零资金启动、全靠两位学生用谷歌 TPU Research Cloud 白嫖算力训练出来的故事,本身就足够励志和吸引人!

用 Dia,你能做什么?

潜力巨大!

- 内容创作:播客、有声书、短视频旁白、AI虚拟主播... 让你的内容声音更生动。

- 语言学习:模拟真实对话,练习听力和口语。

- 游戏/虚拟人:为NPC或虚拟角色赋予更自然、更多变的语音。

- 广告/营销:用富有情感和非语言声音的语音,增强广告吸引力。

想试试?摸摸底和上手姿势

心动了吗?想上手试试 Dia 1.6B 的魔力?

-

尝鲜最快:直奔 Hugging Face Spaces 的在线 Demo (opens new window)!这是最快感受 Dia 魅力的途径。不过注意,当前在线 Demo 主要支持英文。

-

代码玩家:GitHub 仓库 (opens new window)是你的根据地。这里有完整的代码、安装指南、Python API 示例。你可以下载模型权重 (opens new window),然后在本地部署 Gradio 界面,或者直接调用 API 集成到你的应用里。

-

学习资料:Nari Labs 的 Notion 技术文档 (opens new window)里有详细的性能对比、情感控制和声音克隆的指南,非常实用。

-

社区交流:想知道最新进展、交流使用经验?加入 Discord 社区,或者关注 Hacker News (opens new window)上的讨论。

硬核要求:目前,Dia 对硬件还有点要求,推荐 NVIDIA RTX A4000 或更高,需要大约 10GB 显存才能运行。不过别担心,团队已经在计划推出量化版本和 CPU 支持,未来门槛会越来越低。实时生成速度在 A4000 上大概是每秒 40 个 token(大约0.5秒音频),高端卡或多卡能更快。

当前的“小遗憾”:

- 语言:目前主要集中在英语。大家最关心的中文支持... 嗯,中文尚未适配,不过未来计划中,一起期待吧!

- 长文本:处理特别长的文本时,语速可能会有点小问题,调整速度参数可能会影响音调,这些是仍在优化的地方。

总结:开源TTS的新里程碑

Dia 1.6B 的出现,无疑是开源 TTS 领域的一个重要里程碑。它用实际效果证明,即使是小团队,也能凭借创新的技术思路(多角色对话、非语言声音嵌入、情感自适应)和对开源社区的拥抱,打造出能够比肩甚至在某些方面超越商业巨头的产品。

它的高可控性、对话生成能力和对非语言声音的支持,让文本转语音不再是简单的“朗读”,而是更接近真实的“表演”和“交流”。

无论你是研究者、开发者还是内容创作者,Dia 都提供了一个强大且灵活的新选择。虽然目前还有语言等方面的限制,但凭借其核心能力的突破和活跃的开源社区,Dia 的未来绝对值得我们持续关注!

去 Hugging Face 体验一下吧,你会惊喜于它的表现的!

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站

文章评论