各位AI圈的朋友们,大事件来了!最近,阿里巴巴正式开源了他们最新的AI视频模型——通义万相 Wan2.1-VACE。说实话,当我看到它的介绍时,心里只有一个词:“卧槽,这下牛了!”

为什么这么说?因为在AI视频领域摸爬滚打这么久,我们都懂那个痛:生成视频有生成视频的模型,编辑视频有编辑视频的工具,抠图得用这个软件,改个颜色得换那个插件,想控制人物动作又得找别的方案……就像在厨房做满汉全席,刀、勺、锅、碗都得换个遍。

但通义万相 Wan2.1-VACE 直接告诉你:“别折腾了,我一个就够!”

这不是“又一个”视频生成模型,它是“全能一体机”

很多模型都号称能“文生视频”或“图生视频”,Wan2.1-VACE 当然也行,而且能力还很扎实,能根据你的文本描述或参考图片,生成流畅、细节丰富的视频。

但它的杀手锏在于:它不只是个生成器,更是个强大的视频编辑台!而且这一切,都是由同一个模型完成的。

想想看,你可以用它做什么:

- 视频重绘/风格迁移: 一键把写实风变成赛博朋克,或者把实拍视频瞬间二次元化。

- 局部编辑: 就像在视频里用“魔术棒”,框选某个区域,替换掉里面的物体,或者给人物添个配饰,甚至擦掉画面里的某个不和谐元素。

- 对象替换 (Swap-Anything): 想把视频里的猫变成老虎?把路人甲换成你朋友?它能帮你搞定。

- 背景/画面延展: 拍了个竖屏视频想发B站?让它帮你智能补全背景,瞬间变横屏,内容还能自然衔接。甚至能帮你扩展出画面之外的新场景。

- 时长延展: 视频开头或结尾太短?让它智能帮你“脑补”几秒,补全画面内容。

这太夸张了!以前这些操作,要么是后期软件里的专业技术,要么得依赖多个不同的AI模型甚至服务。现在,一个Wan2.1-VACE模型,把这些都打包了!

不止能做,还能“听话”:像素级的精准控制

光能做还不够,AI生成最令人头疼的就是“不可控”。很多时候出来的结果跟我们想的南辕北辙。但Wan2.1-VACE 在“控制”上,下足了功夫。它能让你像个提线木偶师一样,对视频里的元素进行像素级的精准控制。

它是怎么做到的?关键在于它支持的多模态输入。它不只看你的文字Prompt,还能同时“理解”和“参考”多种其他信息:

- 文本 (Prompt): 自然语言描述,这是基础。你可以告诉它“生成一个跑步的人”,但更厉害的是,你可以用它来指挥镜头运动,比如“镜头从左向右平移,焦点对准人物”。

- 图像 (图片参考): 你可以给它一张参考图,告诉它“视频里的角色要长这样”,或者“场景要有这种色调风格”。

- 视频 (原视频编辑): 这是编辑的基础,直接输入你要修改的那个视频。

- 遮罩 (Mask): 这个太重要了!用一个黑白图(Mask),告诉模型“只改这里,别的地方别动”。这就像你用蒙版在Photoshop里编辑图片一样,实现了局部、精确的修改。

- 控制信号: 这才是真正的“魔法控制线”!Wan2.1-VACE 支持输入各种专业的控制信号,来实现你想要的精确效果:

- 深度图 (Depth Maps): 控制画面景深,让远处的虚化,近处的清晰。

- 光流图 (Optical Flow): 这描述了画面中每个像素的运动方向和速度。有了它,你可以精准控制视频里物体的运动轨迹,让它沿着你想要的路径移动,而不是随机乱跑。

- 人体姿态 (Human Poses): 你可以输入一个骨骼图,让视频里的人物摆出你想要的姿势,甚至把一个视频里人物的动作,“迁移”到另一个视频的人物身上。

- 布局图 (Layout Maps): 控制画面元素的排布和构图。

- 线稿/边缘图 (Line Art/Canny): 作为结构参考,让生成的内容遵循特定的轮廓或线条风格。

想想看,你输入一个视频,再加一个Mask,框选人物;然后给一个姿态图,让人物从“站着”变成“跳舞”;再给一个光流图,控制人物跳舞时向左移动三步;同时再给一个文本Prompt,让背景变成“星空”……这一切复杂的操作,理论上只需要一个模型,一次推理就能完成!这种控制力,是很多纯生成模型望尘莫及的。

这一切多模态输入的背后,是 Wan2.1-VACE 采用的“视频条件单元 (Video Conditional Unit, VCU)” 这种巧妙的技术架构,它能把这些五花八门的输入信息,“标准化”后喂给模型处理。

性能与门槛:消费级显卡也能玩转?

之前很多强大的AI模型,不是闭源不公开,就是对硬件要求高到离谱,普通人根本玩不起。Wan2.1-VACE 在这里又带来惊喜。

阿里巴巴这次开源了两个版本:1.3B 参数的轻量版和 14B 参数的“满血”版。重点是,那个 1.3B 版本!根据官方信息和社区测试,它竟然能在消费级显卡上运行!比如,在 RTX 4090 上生成一段几秒钟的 480P 视频,显存占用也就 8.19GB 左右,推理时间大约几分钟。甚至有说法称,在 RTX 3060 这样的显卡上也有跑起来的可能性!

这可是个大事件!它极大地降低了AI视频创作的门槛,让更多个人创作者、小型团队甚至是学生,都有机会接触并使用这种顶尖的AI能力。

当然,14B 版本能生成更高清(720P甚至更高)、质量更好的视频,但对硬件要求也更高,适合专业级工作站。

在性能评测方面,根据官方信息,Wan2.1 系列模型在 VBench 这个视频生成模型综合评测榜单上表现出色,总分高达 86.22%,甚至超越了之前备受关注的Sora和Luma等模型,特别是在动态表现和多物体交互等关键指标上。这意味着它生成的视频不仅流畅,而且能更好地处理复杂场景和物体的互动。

对了,还有一个小亮点,据说 Wan2.1 是首批能准确生成中英文双语文本的视频模型,对于中文用户来说非常友好。

未来已来,触手可及

通义万相 Wan2.1-VACE 的开源,不仅仅是发布了一个模型,更是向整个行业抛出了一块基石。它的“一体化”能力和强大的控制力,预示着AI视频创作将变得前所未有的高效和灵活。

想象一下,未来的视频制作流程:初稿生成、局部修改、风格调整、背景替换、动作微调……所有这些可能都只需要在同一个界面里,通过调整Prompt、Mask或控制信号来完成。这无疑将极大地提升创意效率,降低专业技能门槛。无论是影视后期、广告制作、独立动画,还是我们日常的社交媒体内容创作,都将因此受益。

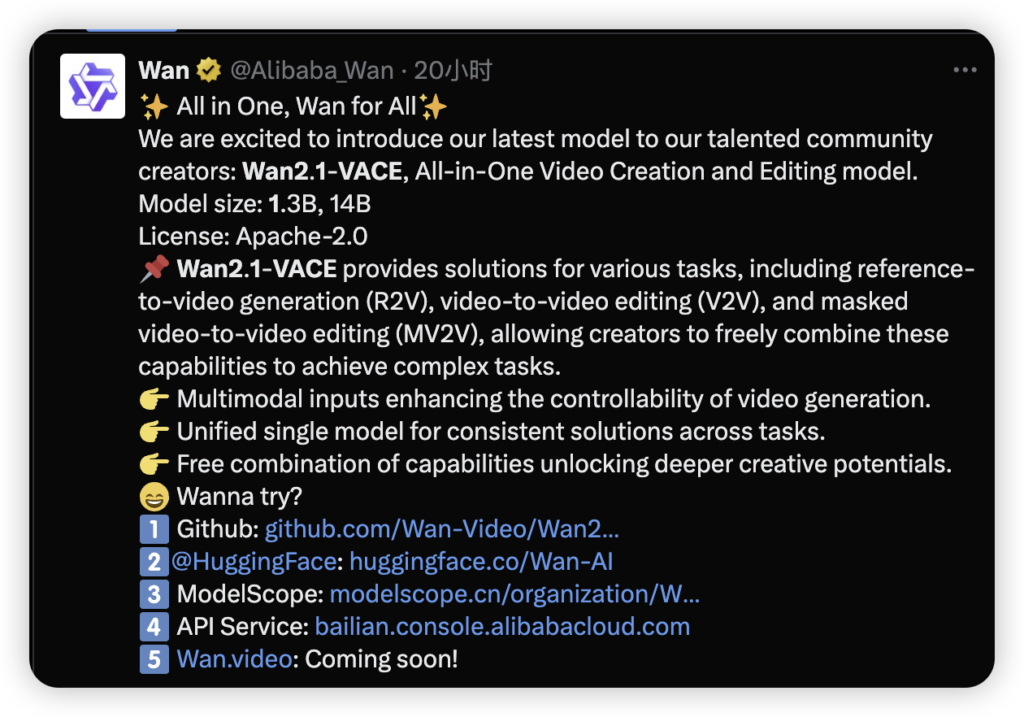

模型的代码、权重已经在 GitHub、Hugging Face 以及阿里云的魔搭社区(ModelScope)上全面开源,遵循友好的 Apache-2.0 许可证,这意味着你可以自由地下载、研究、使用,甚至用于商业用途(当然要遵守许可证条款哈)。

- GitHub: https://github.com/Wan-Video/Wan2.1

- HuggingFace: https://huggingface.co/Wan-AI

- ModelScope: https://modelscope.cn/organization/Wan-Al

虽然官网 http://Wan.video 还在“Coming soon”,但模型本身已经触手可及了!

总而言之,阿里巴巴通义万相 Wan2.1-VACE 的开源,是AI视频领域一个振奋人心的里程碑。它用一个模型打通了生成和编辑的壁垒,用多模态输入赋予了我们前所未有的控制力,更用消费级硬件的支持让这项技术不再是少数人的专利。

AI视频创作的“工业革命”,也许才刚刚拉开序幕,而Wan2.1-VACE,无疑是这场变革中的一位重量级玩家。赶紧去试试吧,未来的AI视频创作者们!

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站

文章评论