老实说,在AI绘画圈子里摸爬滚打了这么久,大家是不是都有点审美疲劳了?

不管是用哪个主流模型,跑多了你总能发现某种“诡异的默契”:千篇一律的完美光影,像是同一个整容医生刀下的“网红脸”,还有那种一眼就能看穿的塑料质感。这种“同质化”就像是AI绘画头顶的一层玻璃天花板,好看是好看,但总觉得少了点灵魂。

不过,就在2026年1月28日,阿里云通义团队搞了个大动作,开源了名为 Z-Image 的基座模型。看完这波技术细节,我感觉这层天花板可能要被敲出裂缝了。

不止是快,更重要的是“原生”

这次发布的 Z-Image 是一个 6B(60亿)参数量的模型。在这个百亿甚至千亿参数横行的年代,6B听起来似乎不算庞然大物,但它的定位非常精准:做一个完美的“底座”。

这就得聊聊这次发布的一个核心关键词——非蒸馏。

之前的很多模型为了追求极速出图(比如所谓的Turbo版),往往使用了蒸馏技术。这就像是把浓缩咖啡兑水变成了速溶,速度是快了,但很多细腻的风味(权重分布)丢失了。而这次开源的 Z-Image Base 版本,保留了全量的权重分布。

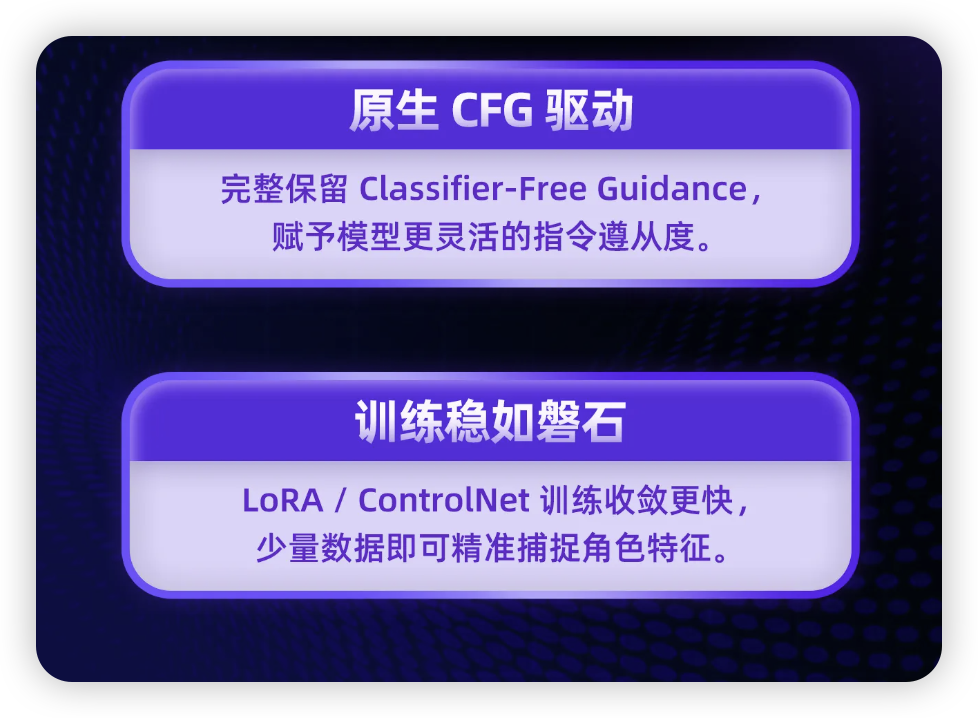

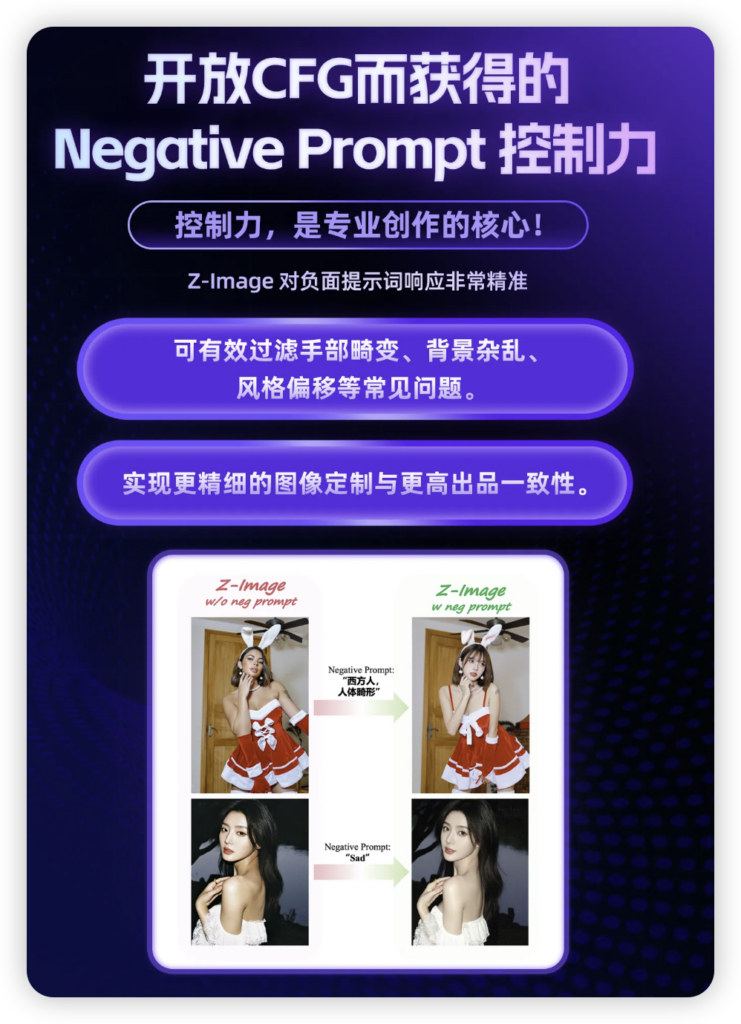

这对我们这些喜欢折腾的人来说意味着什么?意味着它的可塑性极强。它原生支持 CFG 引导机制,更是 LoRA 和 ControlNet 的绝佳温床。如果你想训练一个属于自己独特画风的模型,或者要把自家猫主子炼进去,这个“非蒸馏”的底子绝对比那些为了速度而阉割过的模型要好用得多。

向“AI大众脸”宣战

Z-Image 最让我感兴趣的,是它试图解决“人像同质化”的野心。

官方在技术文档里提到,他们优化了采样空间的分布。翻译成人话就是:它不再总是偷懒去抄那几张最稳妥的“标准脸”作业了。

以前我们抽卡,十张图里有八张脸型差不多,但在 Z-Image 的逻辑里,不同的种子和提示词会真的导向截然不同的面孔特征和构图逻辑。它不仅能驾驭从写实摄影到二次元动漫的跨度,更重要的是,它试图在多人场景中剥离那种“克隆人军团”的感觉。这对于需要做连环画、游戏资产或者故事绘本的创作者来说,简直是刚需中的刚需。

门槛打下来了,玩法升上去了

聊聊配置。6B 的参数量,显存占用控制得相当克制。根据目前的测试,主流的消费级显卡(16GB显存就是一个很舒服的甜点区,甚至更低配置通过量化也能跑)完全能扛得住。

这意味着你不需要租昂贵的A100服务器,在自己的本地电脑上就能跑起来。对于开发者而言,它基于 S³-DiT(单流扩散Transformer)架构,推理效率本身就很高。

写在最后

目前的AI绘图圈,缺的其实不是那种能一秒钟出图的工具,而是缺一个能真正理解“差异化”、能让创作者深度定制的扎实地基。

阿里云通义这次把 Z-Image 的基座开源,显然是想走“生态包围”的路子。虽然官方目前还没把牛吹上天,但作为开源社区的一员,我能预感到,很快 ModelScope 和 Hugging Face 上就会涌现出一大批基于 Z-Image 微调的惊艳模型。

如果你也受够了千篇一律的AI脸,或者想亲手炼制一个真正听话的模型,不妨去魔搭社区或者 GitHub 上把这个权重拉下来试试。毕竟,工具只是画笔,真正的艺术,还得看握笔的人怎么用。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站