2025年的跨年夜,当大多数人还在倒数计时迎接新年的时候,DeepSeek的团队干了一件非常极客的事——他们甩出了一篇重磅论文。 这篇名为《mHC: Manifold-Constrained Hyper-Connections》的论文,看似标题充满了晦涩的数学名词,但实际上,它可能刚刚解开了困扰大模型界已久的一个死结:模型越大,越容易练崩。 今天我们就抛开那些复杂的公式,用人话聊聊这项可能定义“后Transformer时代”的新技术。 贪婪的代价:当“宽带”变成灾难 过去这十年,深度学习能发展这么快,何凯明大神的R…

嘿,AI圈的朋友们!最近DeepSeek团队又搞了个大动作,发布了一款名叫DeepSeek-OCR的开源模型。但你可别以为这只是一个普通的文字识别工具,它的核心理念简直是脑洞大开,可能会彻底改变我们处理长文本的方式。 想象一下,我们的大语言模型(LLM)在面对海量文本时,常常会因为算力消耗过大而头疼不已,上下文一长,计算量就呈平方级增长。DeepSeek-OCR另辟蹊径,它不直接处理文本,而是巧妙地把文本信息“画”成图像,然后对这些图像进行压缩!是不是有点像人类先看图再理解,而不是一个字一个字地嚼? “光学压缩”的…

DeepSeek 真是个神秘又惊喜不断的家伙!就在最近,他们的线上大模型悄然完成了又一次迭代升级,从 DeepSeek-V3.1 华丽转身,正式迎来了 DeepSeek-V3.1-Terminus 版本。这个名字一听就充满了故事感,在拉丁语中,“Terminus”意为“终点”。这难道预示着 V3.1 系列架构的极致完善,一个阶段性的巅峰之作? 没错,这次升级并非单纯追求参数规模上的“更大更强”,而是一次深度聚焦于用户体验、稳定性与专业场景能力上的“精雕细琢”。与其说是终点,我更愿意称之为 DeepSeek 在探索大…

兄弟们,新玩具来了! 就在大家还在争论闭源与开源的未来时,DeepSeek毫无征兆地在Hugging Face上扔出了一颗重磅炸弹——V3.1 Base模型。别看名字只是个“.1”的迭代,这次的升级,在我看来,与其说是参数的堆砌,不如说是一场关乎“效率”与“架构”的精妙胜利。 今天,不谈空泛的商业前景,咱们就以一个开发者的视角,像拆解一块精密的机械表那样,一层层剥开V3.1的外壳,看看它的心脏究竟是如何跳动的。 128K上下文:不只是把内存条加大了 首先,最引人注目的就是那个闪亮的数字:128K tokens。 这…

嘿,AI圈的朋友们! 最近真是热闹非凡!就在大家还在感慨 DeepSeek-R1-0528-Distilled-Qwen3-8B 这匹“黑马”有多强悍时,好消息像坐上了火箭,瞬间传遍了社区——它的各种量化版本,终于来了!这意味着,你那块默默奉献的 RTX 3080 Ti,终于有机会一展身手,本地跑起顶级大模型了! 量化的魅力:显存焦虑?那是什么? 你是不是经常听到:“这模型太大了,我的显存不够!”、“4090 才是人权卡!”?别急,量化技术就是来解决这个痛点的“魔法”! 简单来说,量化就是把模型从“巨无霸”身材“瘦…

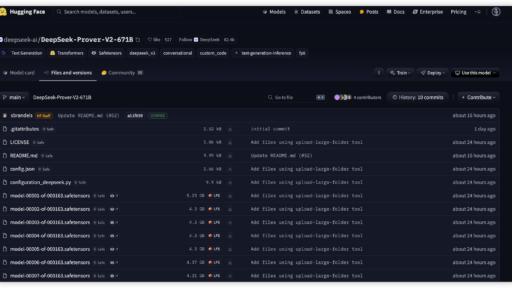

说实话,AI 在文本、图片、甚至代码生成领域已经卷得飞起,但有一个领域一直是“硬骨头”——形式化数学证明。这玩意儿不仅要求强大的逻辑推理能力,还得遵循一套极其严谨、不容出错的符号系统(比如 Lean 4)。直到昨天(2025年4月30日),DeepSeek 突然丢出了一个「王炸」:DeepSeek-Prover-V2-671B,一个参数量高达 6710 亿、专攻数学证明的超大型 MoE 模型,直接把这个领域的 SOTA(State-of-the-Art,当前最佳水平)推到了一个新高度! 这还不算完,DeepSeek…

嘿,各位AIer!今天AI圈又出了个大新闻,一个听起来就带着点神秘色彩的新模型正式亮相了——它就是 DeepSeek-R1T-Chimera!光听名字里的 "Chimera"(奇美拉,神话里的嵌合体怪物),就感觉不简单,对吧? 这可不是DeepSeek官方自己发布的常规升级款哦,它是由一支来自德国的牛人团队 TNG Technology Consulting 搞出来的。他们玩儿了个更花的——拿DeepSeek家最强的推理大模型 DeepSeek-R1 和高效能的 DeepSeek-V3-0324 开刀,来了个“乾坤…

一、DeepSite 是什么? DeepSite 是基于 DeepSeek-V3-0324 大模型的革命性 AI 编程工具,由开发者 enzostvs 打造并托管于 Hugging Face 平台。它通过自然语言交互实现 "氛围编程(Vibe Coding)",用户仅需输入需求描述,即可秒级生成完整应用或游戏代码,并直接在浏览器中运行与托管。其核心特性包括: • 零代码门槛:无需编程基础,用中文描述需求即可生成代码 • 多模态支持:覆盖网页应用、小游戏(如贪吃蛇、五子棋)、3D 交互内容等 • 实时预览:左侧生成代…

一、引言:一场悄然改变AI格局的升级 2025年3月24日,DeepSeek团队以“小版本更新”之名,推出DeepSeek-V3-0324模型,却在AI领域掀起巨浪。这款拥有6850亿参数的混合专家(MoE)模型,以557.6万美元的极低成本完成训练,性能直逼顶级闭源模型Claude 3.7 Sonnet。更令人瞩目的是其MIT开源协议——允许企业免费商用和二次开发,彻底打破闭源技术垄断的围墙。正如开发者社区所言:“这不是一次更新,而是一场技术民主化的革命。” 二、参数与架构:藏在6850亿参数里的技术革命 1. …

引言 随着人工智能技术的飞速发展,HuggingFace作为全球最大的开源AI社区,每周更新的热门模型榜单已成为开发者与研究者关注的“风向标”。根据最新数据,上周的十大热门模型中,中国开源模型表现亮眼,推理与多模态能力成为技术突破的核心方向。以下为具体分析: 十大热门模型解析 1. Qwen/QwQ-32B:开源推理模型的新标杆 参数与类型:32B参数的文本生成模型,专注推理能力。 亮点:阿里通义千问系列的最新成员,不仅登顶HuggingFace模型榜,还在国际权威评测LiveBench中超越OpenAI-GPT-…