各位AI圈的朋友们,最近有没有被微软的一则重磅消息刷屏?2025年10月14日,Redmond的巨头正式揭开了它首款自研图像生成模型的面纱——MAI-Image-1。这可不只是又一个模型那么简单,它背后藏着微软在生成式AI领域的一次战略大转向,堪称一次“断奶”行动! 战略转向:从“依赖”到“自立” 一直以来,微软在图像生成这块,大伙儿都知道,大部分功能都得仰仗合作伙伴OpenAI的DALL·E系列。这虽然是强强联合,但对于一家志在全面掌控AI未来的科技巨头来说,核心技术的“卡脖子”问题始终是个心结。MAI-Imag…

在AI浪潮席卷全球的当下,我们见证了无数模型的诞生,它们或以参数规模震撼世人,或以应用落地改变生活。但真正能引发深思、指向未来的,往往是那些敢于打破既定范式,注入全新理念的探索。而今,来自瑞士的Apertus,无疑就是这样一位令人眼前一亮的“新玩家”。 2025年9月初,当瑞士顶尖科研机构——洛桑联邦理工学院(EPFL)、苏黎世联邦理工学院(ETH Zurich)和瑞士国家超级计算中心(CSCS)联合官宣Apertus的正式发布时,整个AI社区为之侧目。它并非只是一款技术产品,更是一份关于AI未来的宣言——一份来自…

在AI生成内容的浪潮之巅,视频领域始终是那块最难啃的硬骨头。当许多人还在为生成画面的稳定性和真实感苦恼时,阿里通义万相Wan2.2携着一身“黑科技”悄然登场,它所做的不仅仅是迭代,更像是一场对视频创作门槛的颠覆性革命。 两位“专家”,一位导演——聊聊它的智慧核心 想象一下,拍摄一部电影,你需要一位总揽全局的导演,负责构图和故事节奏;还需要一位精益求精的摄影师,负责光影和细节质感。Wan2.2的“混合专家(MoE)”架构,正是这样做的。 这是业界首次将MoE引入视频模型。它巧妙地将模型分为“高噪声专家”和“低噪声专家…

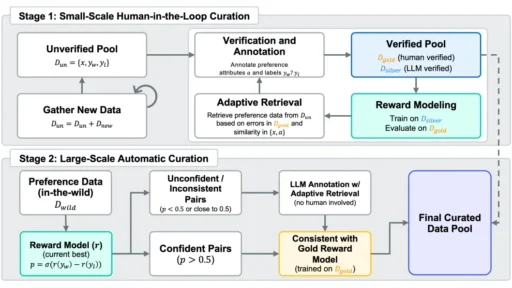

各位,划重点了!就在 2025年7月4日,昆仑万维再次把他们最新的 AI 心脏——Skywork-Reward-V2 系列奖励模型,打包开源了!这不是普通的模型更新,这简直是 AI 领域的一场“小型地震”,还是那种威力巨大但又悄无声息的。 💥 参数“瘦身术”成新宠:0.6B 硬刚 70B? 让我来给你捋一捋这次的“怪事”。这次的 Skywork-Reward-V2 系列,玩的是参数“瘦身术”,但实力却像开了外挂一样暴涨! 模型阵容强大:从 6亿(0.6B)到80亿(8B)参数,足足 8个不同身材 的奖励模型,基座还…

一、引言:一场悄然改变AI格局的升级 2025年3月24日,DeepSeek团队以“小版本更新”之名,推出DeepSeek-V3-0324模型,却在AI领域掀起巨浪。这款拥有6850亿参数的混合专家(MoE)模型,以557.6万美元的极低成本完成训练,性能直逼顶级闭源模型Claude 3.7 Sonnet。更令人瞩目的是其MIT开源协议——允许企业免费商用和二次开发,彻底打破闭源技术垄断的围墙。正如开发者社区所言:“这不是一次更新,而是一场技术民主化的革命。” 二、参数与架构:藏在6850亿参数里的技术革命 1. …