🍎 Mac本地部署DeepSeek蒸馏模型指南:Ollama极简手册

——让你的Mac变身“AI小钢炮”💥

一、准备工作:Mac的“硬件咖啡豆研磨器”

1.1 最低配置要求

| 组件 | 入门级(7B模型) | 旗舰级(33B模型) |

|---|---|---|

| 芯片 | M1(2020款) | M2 Pro/Max(2023款) |

| 内存 | 8GB(需关闭Chrome) | 32GB(可边跑AI边刷剧) |

| 硬盘 | 15GB空间(留点地方给猫片) | 100GB+(模型全家桶爱好者) |

| 系统 | macOS Monterey 12.3+ | Ventura 13.1+(推荐) |

📌 冷知识:DeepSeek蒸馏模型=原模型的"精华萃取版",体积缩小40%,性能保留85%!

1.2 必备软件

- Ollama:模型管理神器(官网)

- Homebrew:Mac界的软件百宝箱

-

Python 3.10+:建议通过Miniforge安装ARM原生版

二、安装步骤:3步召唤AI小精灵🧞

Step 1:安装Ollama(比泡面还快)

# 一键安装(终端输入)

/bin/bash -c "$(curl -fsSL https://ollama.ai/install.sh)"

# 验证安装(看到版本号就算成功)

ollama --version

# 输出示例:ollama version 0.1.12 darwin/arm64 Step 2:下载DeepSeek模型(选你爱的口味)

# 基础编程模型(程序员必装)

ollama pull deepseek-coder-7b

# 聊天模型(含互联网最新知识)

ollama pull deepseek-chat-7b

# 国内加速技巧(替换镜像源)

OLLAMA_MODELS=https://mirror.example.com ollama pull deepseek-math-7b Step 3:启动对话(和AI说“嗨”)

# 基础模式

ollama run deepseek-chat-7b "用东北话解释量子纠缠"

# 高级模式(开启GPU加速)

OLLAMA_GPU_LAYER=metal ollama run deepseek-coder-7b 三、模型对比:找到你的“灵魂伴侣”🤖

| 模型名称 | 内存占用 | 硬盘需求 | 推理速度 | 擅长领域 |

|---|---|---|---|---|

| 1.3B | 2.4GB | 0.8GB | ⚡⚡⚡⚡ | 数学计算/快速问答 |

| 7B | 8GB | 4GB | ⚡⚡⚡ | 代码生成/日常对话 |

| 13B | 16GB | 8GB | ⚡⚡ | 创意写作/专业咨询 |

| 33B | 32GB+ | 16GB | ⚡ | 论文润色/复杂推理 |

💡 选择建议:

- M1用户:7B模型是甜蜜点

- M2 Pro用户:可挑战13B模型

- 内存焦虑症患者:试试

--num-gpu 50%限制显存

四、黄金搭档软件:生产力开挂套装🚀

4.1 交互神器

-

Chatbox:颜值爆表的聊天界面

brew install --cask chatbox

- Ollama WebUI:浏览器随时访问

docker run -d -p 3000:3000 -v ollama:/root/.ollama -e OLLAMA_HOST=127.0.0.1:11434 ghcr.io/ollama-webui/ollama-webui:main

4.2 开发神器

- VS Code插件:

- Continue:代码自动补全

- Ollama Assistant:侧边栏直接对话

4.3 效率神器

五、本地部署的5大核弹级优势💣

5.1 隐私安全

- 你的聊天记录不会成为训练数据(想象和AI吐槽老板的内容被上传...😱)

5.2 离线王者

# 飞机上写代码成就达成!

sudo ifconfig en0 down && ollama run deepseek-coder-7b 5.3 定制自由

- 魔改提示词:

SYSTEM_PROMPT = "你现在是精通阴阳怪气的北京出租车司机" - 加载私人知识库:

ollama run deepseek-rag-33b --attach ~/Documents/my_knowledge.zip

5.4 成本控制

| 方案 | 7B模型年成本 |

|---|---|

| 云端API | ≈$720(按$0.002/1k tokens) |

| 本地部署 | $0(电费≈一杯奶茶钱) |

5.5 硬件压榨

- M系列芯片的神经网络引擎(ANE)火力全开

- 外接显卡扩展:

# 使用eGPU加速(AMD显卡限定) OLLAMA_GPU_LAYER=rocm ollama run deepseek-13b

六、常见问题急救包🆘

Q1:下载模型卡住怎么办?

# 国内镜像加速(任选其一)

export OLLAMA_MODELS=https://mirror.example.com

export OLLAMA_HOST=mirror.ghproxy.com Q2:内存爆炸怎么救?

# 启用4-bit量化

ollama run deepseek-7b --quantize q4_1

# 限制GPU使用率

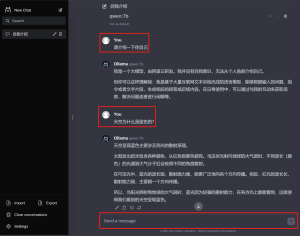

OLLAMA_GPU_UTILIZATION=50% ollama run... Q3:如何让AI记住对话?

# 启动时加载历史记录

ollama run deepseek-chat-7b --history-file ~/ai_chat_history.json 🎁 终极彩蛋:模型变身指南

# 让AI用甄嬛体写代码注释

ollama run deepseek-coder-7b --prompt-template "说句代码注释便是极好的,倒也不负恩泽。n{{.Prompt}}"

# 创建私人模型分身

ollama create my-ai -f Modelfile # 内含自定义指令 现在,你的Mac已经解锁AI超能力!遇到问题时记住:

“重启解决90%的问题,剩下的10%需要再喝一杯咖啡☕”

如果想使用在线的R1模型 可以去硅基流动官网 申请在线API使用 在我的往期教程里面就有

文章评论