大家好!今天咱们不聊那些枯燥的公式和代码,来点儿轻松有趣的,一起扒一扒最近火遍全网的 AI 内容生成 (AIGC) 大模型,看看它们背后的“变形金刚”—— Transformer 架构,到底是个什么神奇的存在!

Transformer:AI界的“最强大脑”

想象一下,如果 AI 也有大脑,那 Transformer 绝对是当之无愧的“最强大脑”!它就像一个超级高效的信息处理中心,能快速理解文字、图像,甚至音乐,然后“嗖”的一下,就能给你变出文章、画作、代码,简直是 AI 界的“变形金刚”!

“自注意力”:让AI学会“察言观色”

Transformer 最厉害的招数,叫做“自注意力 (Self-Attention)”。这玩意儿听起来高大上,其实挺好理解。就好像咱们人类在阅读时,会根据上下文来理解每个词语的意思。比如,我说“苹果真好吃”,你肯定知道我说的是水果,而不是手机品牌。

“自注意力”就是让 AI 也学会“察言观色”。当它处理一句话时,会同时关注这句话里的所有词语,然后判断哪些词语和当前正在处理的词语关系最密切。关系越密切,注意力就越高。这样一来,AI 就能更好地理解句子中每个词语的真正含义,以及它们之间的复杂关系,再长的句子,再绕的弯弯,它也能 hold 住!

“多头注意力”:AI也爱“集思广益”

如果只有一个“大脑”,那可能考虑问题还不够全面。Transformer 就聪明地搞出了“多头注意力 (Multi-Head Attention)”。这就像 AI 有了好几个“小分队”,每个小分队都用不同的角度和方法去“审视”输入的信息。

有的“小分队”可能擅长关注语法结构,有的擅长理解语义,有的擅长捕捉情感色彩……最后,大家再把各自的“看法”汇总起来,综合分析,得出的结论自然就更准确、更深刻啦!这就像我们人类开会,集思广益,才能把事情做得更好嘛!

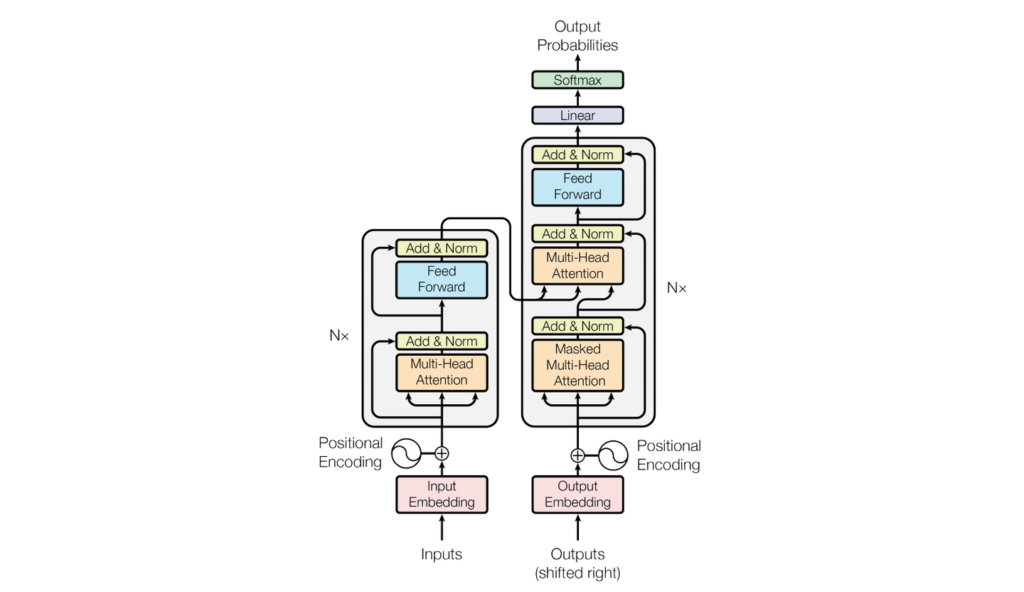

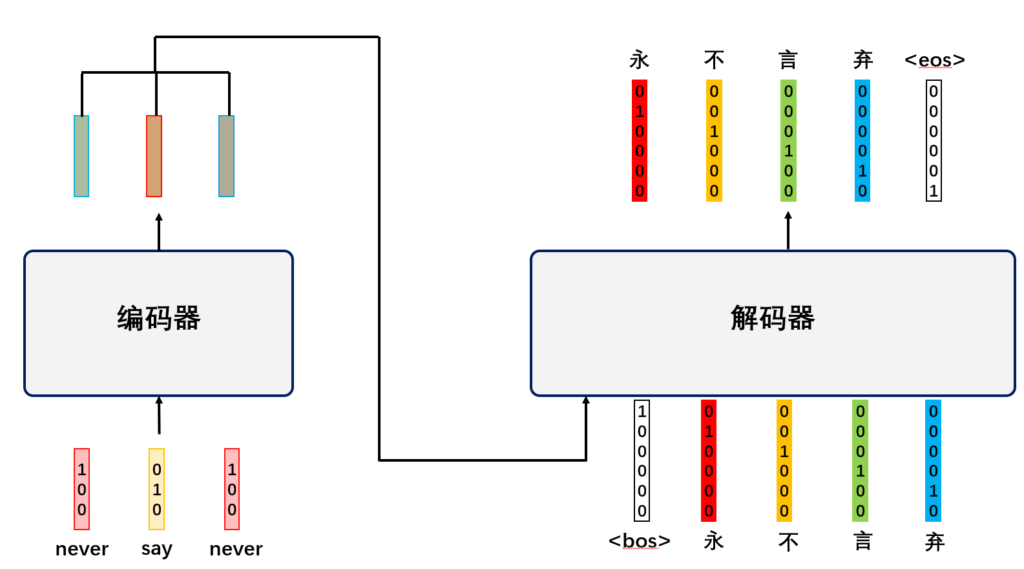

Transformer 的“变形”大法:编码器和解码器

Transformer 这“变形金刚”可不是白叫的,它还能根据不同的任务,变幻出不同的形态。最常见的形态就是“编码器 (Encoder)”和“解码器 (Decoder)”。

-

编码器 (Encoder):就像一个“信息压缩大师”,负责把输入的文字、图像等信息,压缩成 AI 能理解的“精华版”。想象一下,把一本厚厚的书,浓缩成几页纸的精华摘要,编码器就干这个活儿!

-

解码器 (Decoder):则像一个“内容生成魔术师”,它接收编码器压缩的“精华信息”,然后“唰唰唰”地就能变出各种你想要的内容,比如文章、对话、代码等等。解码器就像一个作家、画家、程序员,用 AI 的方式进行创作!

Transformer 为啥这么牛?

为啥 Transformer 这么厉害,能成为 AIGC 大模型的“标配”呢?

-

能“一心多用”:“自注意力”机制让 Transformer 可以并行处理信息,就像我们人类可以同时关注很多事情一样,效率杠杠的!

-

“记忆力超群”:Transformer 能记住句子中很远的信息,不会像以前的 AI 模型那样“记性差”,忘了前面说过啥。这对于生成长篇文章、复杂对话非常重要!

-

“变形能力强”:Transformer 可以根据不同任务“变形”成不同的结构,既能做“阅读理解”,又能搞“内容创作”,简直是“全能型选手”!

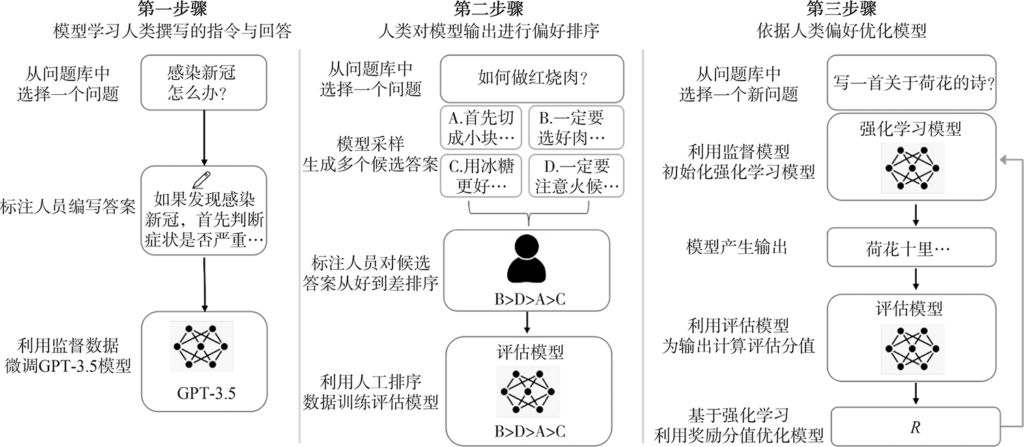

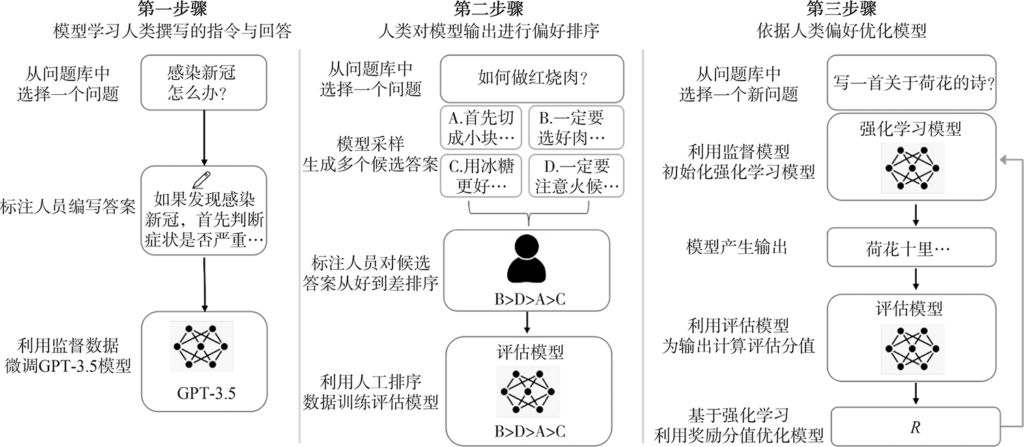

Transformer 的“修炼之路”:预训练和微调

Transformer 大模型也不是天生就这么厉害的,它们也需要“修炼”才能成才。它们的“修炼之路”主要分两步:

-

预训练 (Pre-training):就像 AI 上“大学”,海量阅读各种书籍、文章、代码,学习各种通用知识和语言规律,打下坚实的基础。

-

微调 (Fine-tuning):就像“大学毕业找工作”,根据具体的应用场景 (比如写小说、做客服、画画),用特定的数据集进行“专项训练”,让 AI 掌握特定技能,更好地完成特定任务。

Transformer 的“小烦恼”:幻觉和可解释性

Transformer 大模型虽然很强大,但也不是完美的,它们也有一些“小烦恼”,比如:

-

“幻觉” (Hallucination):有时候,AI 模型会“一本正经地胡说八道”,生成一些听起来很像那么回事,但实际上是错误或虚构的内容。这就像 AI 模型有时候会“做白日梦”,自己编故事。

-

“黑箱” (Black Box):Transformer 模型的内部运作机制比较复杂,我们很难完全理解 AI 是如何做出决策的。这就像我们知道电脑能算数,但很难理解芯片内部的电子是如何运作的。

不过,科学家们正在努力解决这些“小烦恼”,让 Transformer 模型变得更可靠、更可信、更易于理解。

Transformer 的未来:无限可能!

Transformer 架构的出现,就像给 AI 领域装上了“涡轮增压发动机”,极大地推动了 AIGC 技术的发展。现在,我们已经看到了各种基于 Transformer 的 AIGC 应用,比如 AI 聊天机器人、AI 绘画、AI 写作等等,未来还会有更多惊喜等着我们!

所以,下次当你看到 AI 生成的精美画作、流畅文章,或者和你对答如流的 AI 聊天机器人时,别忘了,这背后都有“变形金刚”—— Transformer 的功劳!让我们一起期待,Transformer 将会把 AI 带向怎样更精彩的未来吧!

希望这篇趣味性文章能让你对 Transformer 架构有一个更轻松有趣的了解!如果你想更深入地学习 Transformer 的技术细节,可以继续追问我更技术性的问题哦!😉

文章评论