嘿,各位AI爱好者们!是不是觉得那些动辄几十亿、上百亿参数的大模型离我们遥不可及?是不是还在羡慕别人那强大的 N 卡集群,而自己的 MacBook 只能默默地吃灰?别急!今天我要给你们安利一个宝藏项目,它能让你手里的苹果设备瞬间变身一个强大的“大模型炼丹炉”—— mlx-lm-lora!

想象一下,不用再为显卡价格望而却步,不用再忍受远程服务器的延迟,你完全可以在自己的 Mac 上,为那些顶级大模型量身定制专属的“小助手”,比如更懂你口味的聊天机器人、更懂你行业知识的专家助手……是不是听起来就有点小激动?

什么是 mlx-lm-lora?—— MLX 的神奇助力!

首先,得提一提它的底气:MLX。这可是苹果爸爸专为自家芯片(M1、M2、M3……你懂的!)量身打造的机器学习框架。它的厉害之处在于,能让 CPU 和 GPU 之间的数据传输变得像呼吸一样自然,几乎没有损耗。这就意味着,在苹果设备上运行和训练模型,那叫一个丝滑!

而 mlx-lm-lora 正是巧妙地抓住了 MLX 的这个优势,再加上一个叫 LoRA (Low-Rank Adaptation) 的绝技!这 LoRA 是什么?简单来说,就是不用大费周章地去改动整个模型,只用给它“加装”一些小小的、聪明的“适配器”,就能让模型在特定任务上表现得“判若两人”。这些适配器不仅训练起来贼快,而且体积也小巧,方便分享和切换,简直是模型微调界的“百变星君”!

不止 LoRA,还有“神级”调教术!

更绝的是,mlx-lm-lora 可不只是简单的 LoRA 微调,它还内置了当下最前沿的几种“偏好对齐”训练大法:

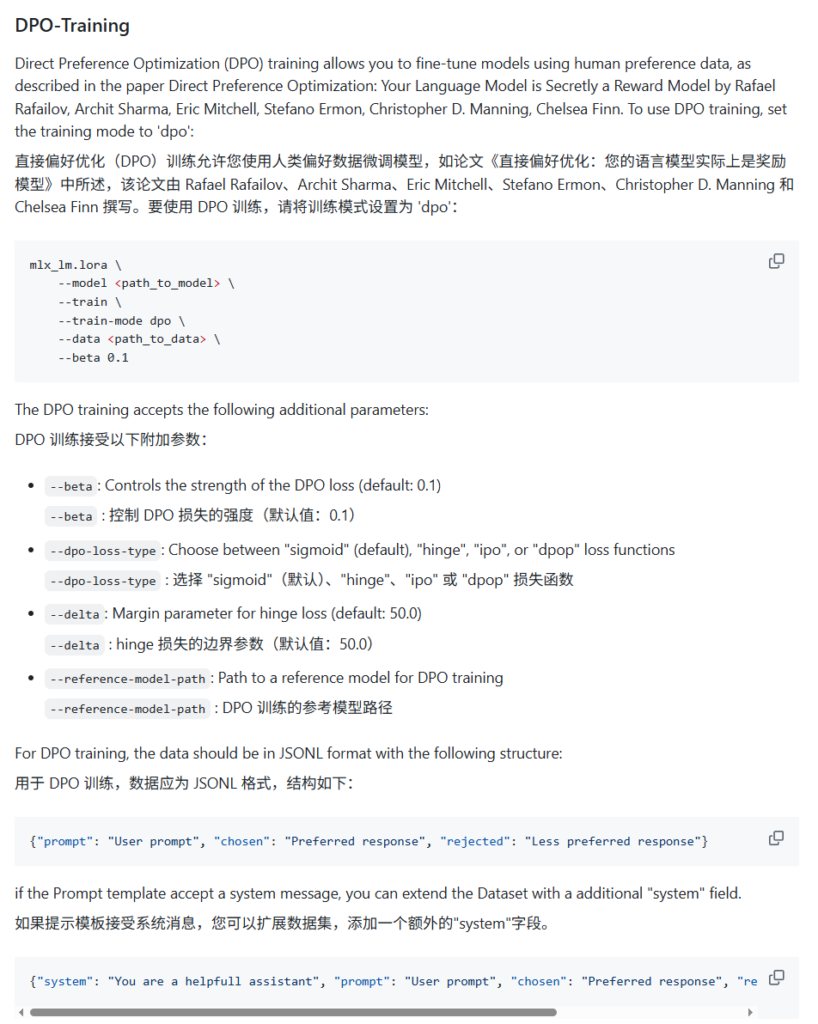

- DPO (Direct Preference Optimization):就像是直接告诉模型“这个好,那个不好”,让它自己领悟什么才叫“人类的赞美”!省去了复杂的奖励模型环节,训练更直接。

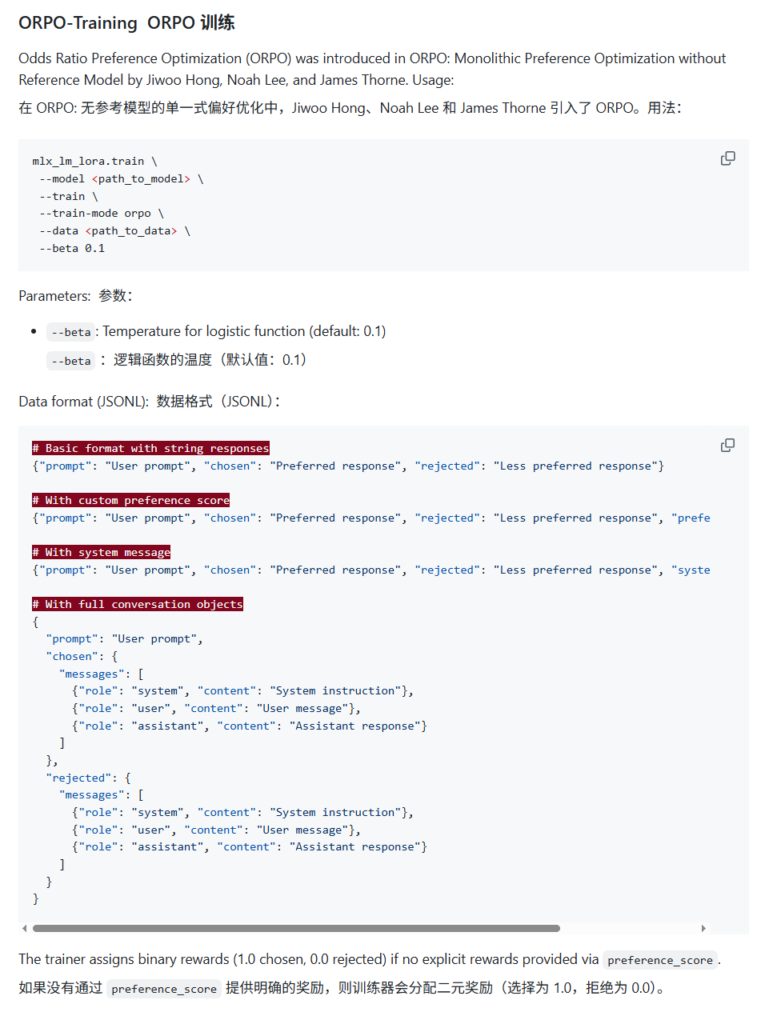

- ORPO (Odds Ratio Preference Optimization):这是一个“集大成者”,它能把“指令遵循”和“偏好对齐”这两个步骤直接合二为一!想想看,一次训练就能让模型既听话又懂你心意,这得多省事!

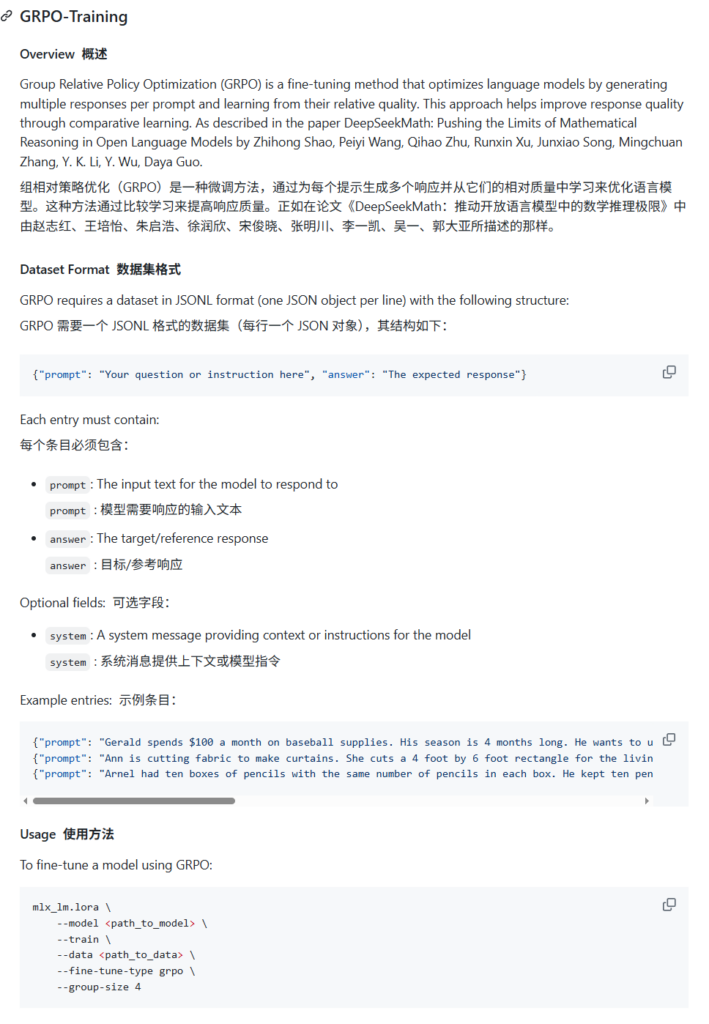

- CPO (Contrastive Preference Optimization) 和 GRPO (Group Relative Policy Optimization):这俩就更像是“精益求精”的代表了,一个强调对比学习,一个优化分组策略,总有一种能让你模型的表现更上一层楼。

有了这些“神级”调教术,你就能让大模型输出的内容,不仅聪明,还特别合你的心意!

怎么上手?—— Mac 上的“炼丹术”入门

别看听着技术范儿十足,实际操作起来,项目提供的 CLI 工具就像是给你的“炼丹炉”装上了智能控制面板。

- 装个apprentiсe:先给你的 Mac 装上

mlx-lm-lora。pip install mlx-lm-lora - 准备“食材”:你需要一个你想微调的模型(比如 Llama 3、Mistral 等,都支持!)和一些训练数据。如果想玩偏好对齐,数据就得是那种“我喜欢这个回答”和“我不喜欢那个回答”配对的形式。好在社区里已经有像

mlx-community/orpo-dpo-mix-40k-flat-mlx这样可以直接用的数据集,省心不少! - 点火开炼!:然后,你就可以像下面这样,用命令行给你的“炼丹炉”下达指令了(以 ORPO 为例):

mlx_lm_lora.train \

--model Qwen/Qwen2.5-3B-Instruct \ # 指定你想“改造”的模型

--train \

--data mlx-community/orpo-dpo-mix-40k-flat-mlx \ # 喂入你的“食材”

--train-type lora \ # 选择 LoRA 微调技术

--train-mode orpo \ # 指定 ORPO 这个“大杀器”

--beta 0.1 \ # 再给点“调味剂”控制效果

... # 其他你想要的配置是不是感觉像是在玩什么高级的模拟游戏?而且项目里还有各种详细的 Notebook 示例,手把手教你如何操作,即使是新手也能很快上手。

为什么你应该试试?

- 告别硬件焦虑:你的 MacBook Pro 就能胜任大模型微调,省下一大笔显卡开销。

- 效率飞起:MLX 的加持加上 LoRA 等高效技术,训练速度让你惊喜。

- 定制你的专属AI:想让你的大模型更懂你的行业?更会说你家乡话?或者写诗更浪漫?没问题,LoRA 适配器都能帮你实现!

- 社区力量:项目在社区里非常活跃,你遇到的问题很可能已经有人解决了,或者你可以直接在 GitHub 上提问,大家都很乐意交流。

总之,mlx-lm-lora 项目就像是给所有苹果设备用户打开了通往“个性化大模型”世界的大门。它不仅降低了技术门槛,更带来了前所未有的灵活性和创造力。快来试试,让你的 Mac 不再只是一个好用的笔记本,更是你手中的“AI 魔法杖”吧!

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站

文章评论