想象一下,你的手机、你的智能音箱、甚至是你的汽车,不再仅仅是连接云端的“传声筒”,而是拥有真正独立思考能力的“智慧大脑”。这听起来是不是像科幻电影里的情节?然而,面壁智能(OpenBMB)最近发布的 MiniCPM 4.1-8B 模型,正将这一愿景变为现实。它不仅带来了强大的AI能力,更将“高效深思考”这一前沿概念,首次真正引入了我们触手可及的端侧设备。

我们都知道,大型语言模型(LLM)的智慧令人惊叹,但它们动辄百亿、千亿的参数量,让许多人望而却步,更别提在资源受限的手机、平板上运行了。这就像是一头大象,即使再聪明,也无法优雅地跳芭蕾舞。MiniCPM 4.1-8B 的出现,恰恰打破了这种僵局,它用一套“四维系统性创新”的组合拳,让“大象”也能翩翩起舞。

解锁“深思考”的秘密武器

那么,MiniCPM 4.1 是如何让小巧的设备也能拥有“深思考”能力的呢?

1. 告别“逐字扫描”,拥抱“高效抽查”:InfLLM v2 稀疏注意力

传统的大模型在处理长文本时,每个词都要像“福尔摩斯”一样,仔细检查序列中所有的其他词,这导致计算量随文本长度平方级暴增。端侧设备哪吃得消这种消耗?MiniCPM 4.1 引入的 InfLLM v2 可训练稀疏注意力机制,就像给模型装上了一双“慧眼”。它不再“逐字扫描”,而是学会了“分块抽查”,智能地识别并只关注那些最关键、最相关的信息。想象一下,在处理一篇128K的长文时,模型只需关注不到5%的词元,计算开销瞬间降至原来的十分之一!这就像一位经验老到的读者,一眼就能抓住文章重点,大大提升了阅读效率。

2. 智能“双频换挡”:速度与精度兼得

效率高了,精度会不会受影响?MiniCPM 4.1 聪明地解决了这个问题。它内置了双频换挡机制,能够像汽车的变速箱一样,根据任务类型和文本长度,智能地切换工作模式。当处理长文本或需要复杂推理的任务时,它会切换到高效的“稀疏模式”;而当处理短文本或对精度有极高要求时,则切换回传统的“稠密模式”。这种灵活的调度,确保了在不同场景下都能达到最佳的平衡,让模型既跑得快,又想得准。

3. “瘦身健体”,硬件普惠:端侧适配的深度优化

光有聪明的架构还不够,关键是要能“落地”。MiniCPM 4.1 在端侧适配上做到了极致。在处理128K长文本时,它所需的缓存空间仅为同类模型的25%!同时,提供了4-bit等多种量化版本,大大降低了对硬件的要求。这意味着,无论是高端显卡、普通笔记本电脑,甚至是你的移动设备和IoT设备,都能流畅运行。这无疑是对硬件门槛的极大解放,让AI的普惠性迈上了一个新台阶。

性能飞跃,刷新认知

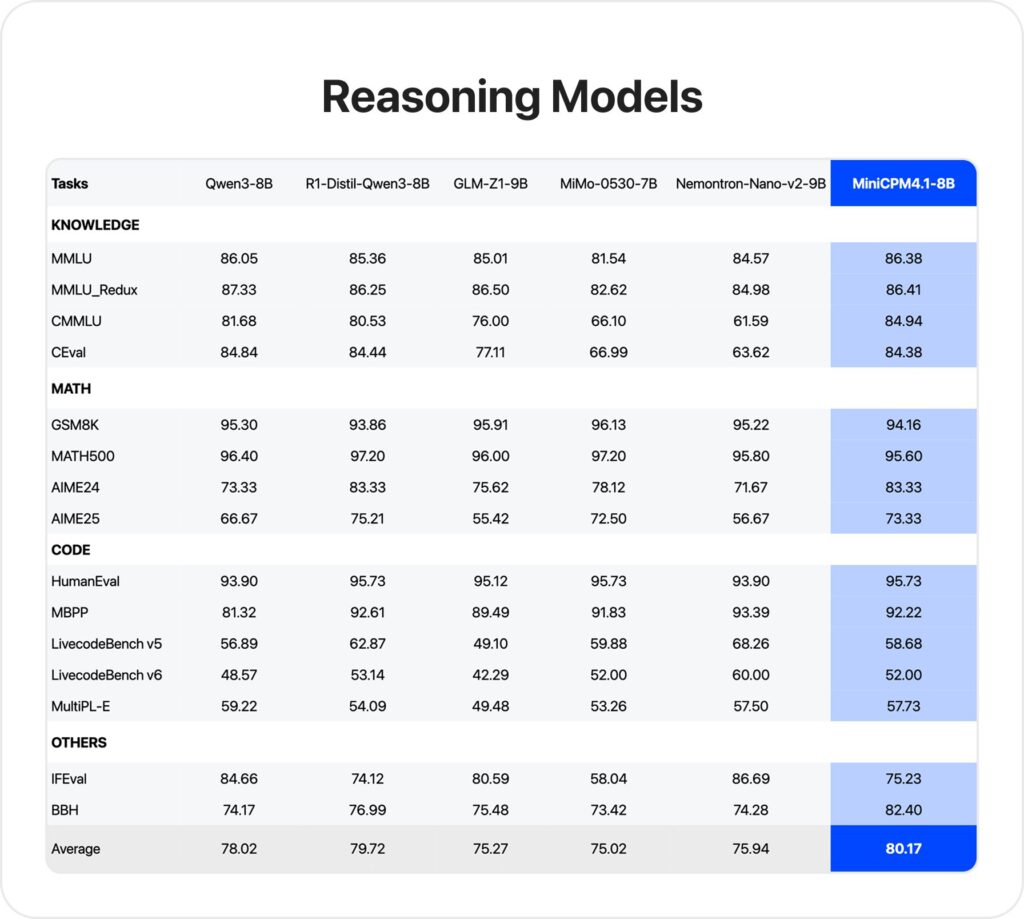

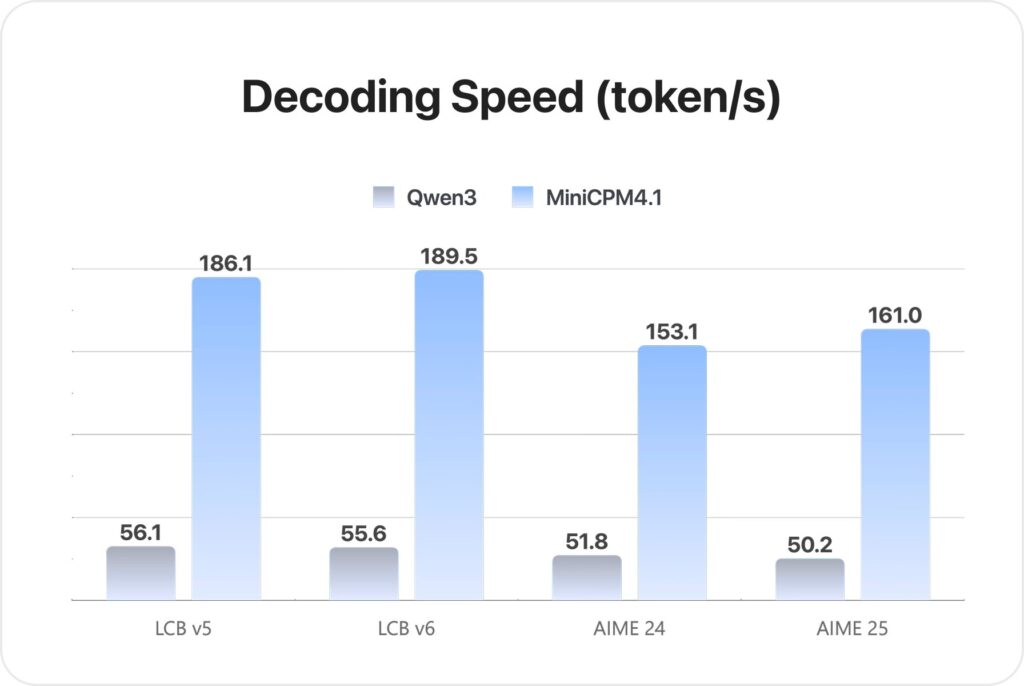

这些创新的综合作用,使得 MiniCPM 4.1 在性能上取得了显著突破。在知识、推理、编程、指令遵循等15个评测基准上,它综合平均分位列同尺寸模型第一。更令人兴奋的是,在端侧设备上,其推理速度更是提升了3倍以上!这意味着你的设备能更快地响应你的指令,提供更即时、更流畅的智能体验。

开源生态,触手可及

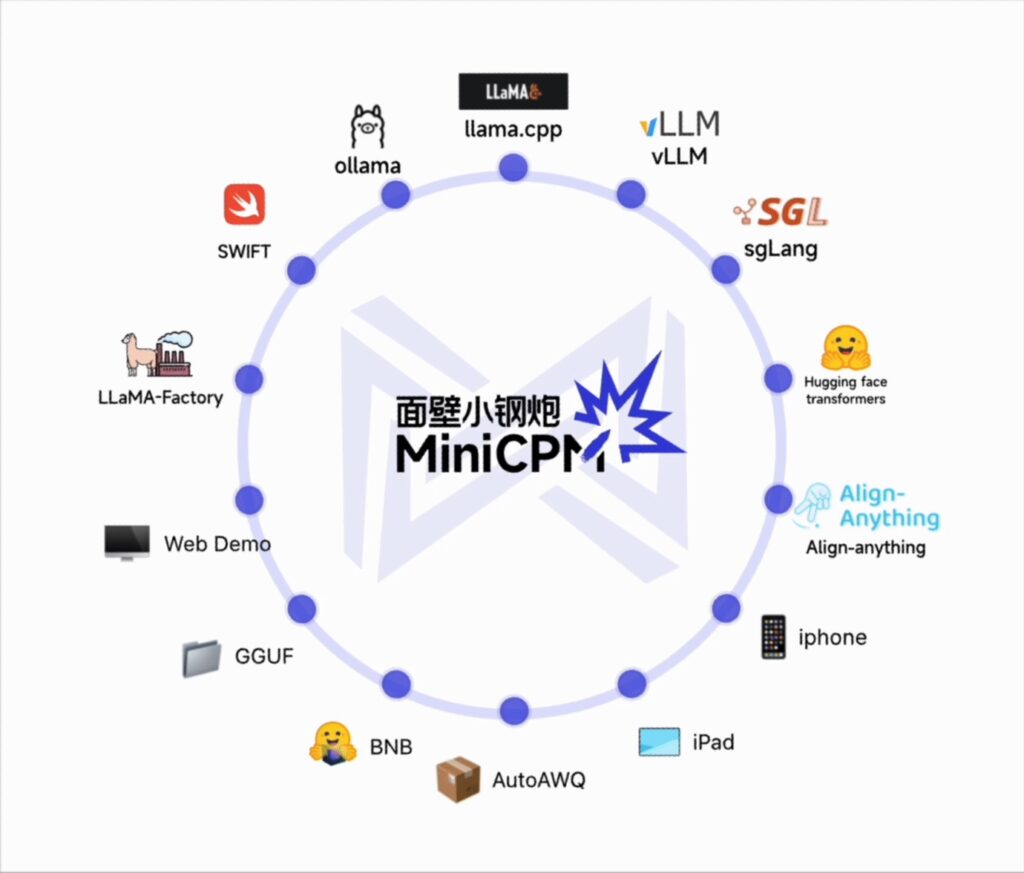

更值得称道的是,MiniCPM 4.1 秉持开源精神,遵循 Apache 2.0 许可证,并支持 Ollama、vLLM、llama.cpp 等主流开源框架部署。这不仅意味着开发者可以免费商用,更代表着一个充满活力的生态系统正在形成,未来会有更多基于 MiniCPM 4.1 的创新应用涌现。

端侧AI的未来已来

MiniCPM 4.1 的发布,不仅仅是一个模型的更新,它更像是一张通往端侧智能未来的门票。通过稀疏注意力、双频换挡和深度端侧优化,它让过去只存在于云端的“深思考”能力,真正来到了我们身边的各种设备上。

试想一下,当你的手机能在没有网络的情况下,为你总结冗长的会议记录;当你的车载系统能实时、私密地理解你最复杂的导航需求;当智能家居设备无需云端也能聪明地管理你的生活……这些场景不再是遥不可及的梦想。MiniCPM 4.1 正在开启一个全新的篇章,一个让每台设备都能拥有“高效深思考”能力,让AI真正融入我们日常生活的智能时代。如果你也对这样的未来充满好奇,不妨亲自去体验一下这款模型,感受端侧AI带来的变革力量!

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站