哎呀,各位AI圈的朋友们,视频创作爱好者们,以及所有被AI视频里那些“不稳定”角色折磨过的各位,一个重磅好消息来了!

就在2025年5月9日,腾讯混元团队甩出了一个“王炸”——他们正式发布并宣布开源了全新的多模态定制化视频生成工具 Hunyuan Custom!

这可不是又一个平平无奇的视频生成模型,它直戳目前AI视频生成领域最让人头疼的一个痛点:主体一致性!简单说,就是如何让AI生成的视频里的人物或物体,在不同场景、不同动作下,还能保持“你是你,我是我”,不会动着动着就换了一张脸,或者物体形态飘忽不定。

腾讯混元这次可是相当硬气,直接宣称,Hunyuan Custom在主体一致性上的效果,已经超越了目前市面上的主流开源方案!这感觉,就像是AI视频里的“灵魂绑定”技术,终于成熟了!

那么,这个Hunyuan Custom到底是个啥?它凭啥能解决这个“变脸怪”问题?

想象一下,你想要用AI生成一个关于“小明在海边冲浪”的视频。你给了AI一张小明的照片,再告诉它“小明在冲浪”。结果呢?可能第一秒小明是这个样,下一秒板子一动,他就变成了另一个人,再过一会儿,海浪一来,他可能又变回去了...是不是很崩溃?这就是主体一致性问题。

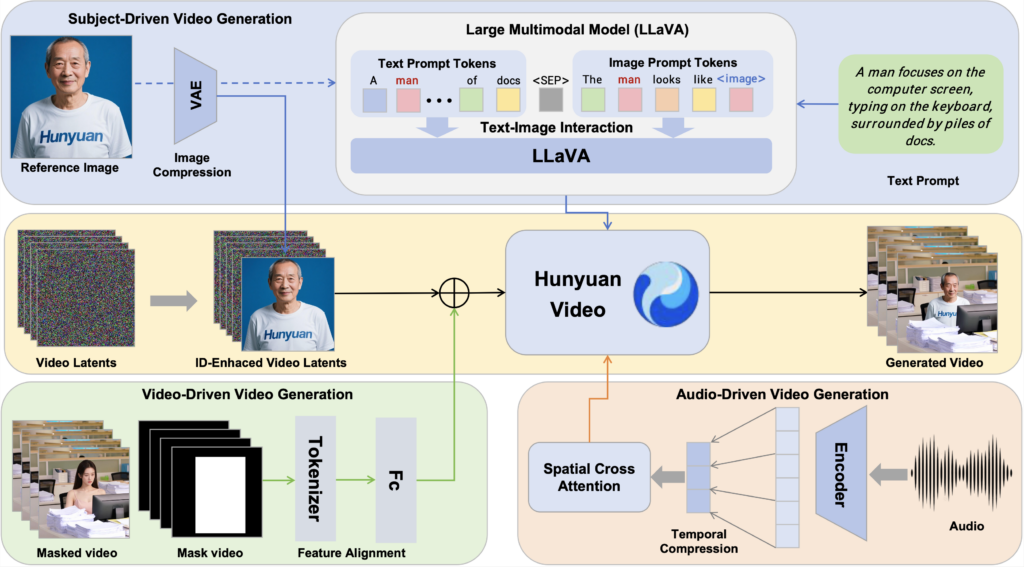

Hunyuan Custom 就是来拯救你的!它是基于腾讯强大的混元视频生成大模型(Hunyuan Video) 构建的,继承了老大哥的视频生成底子,但在此基础上,它学会了一个绝活——“认准你了,就不会轻易变!”

它最牛的地方在于它的多模态能力和高度可控性。你可以给它喂各种东西:

- 一段文字: 描述你想要什么场景、什么动作。

- 一张或多张图片: 告诉它视频里的主角长什么样,或者要出现哪些物体。

- 一段音频: 让视频里的人物按照音频来说话,实现口型同步(想象一下数字人主播!)。

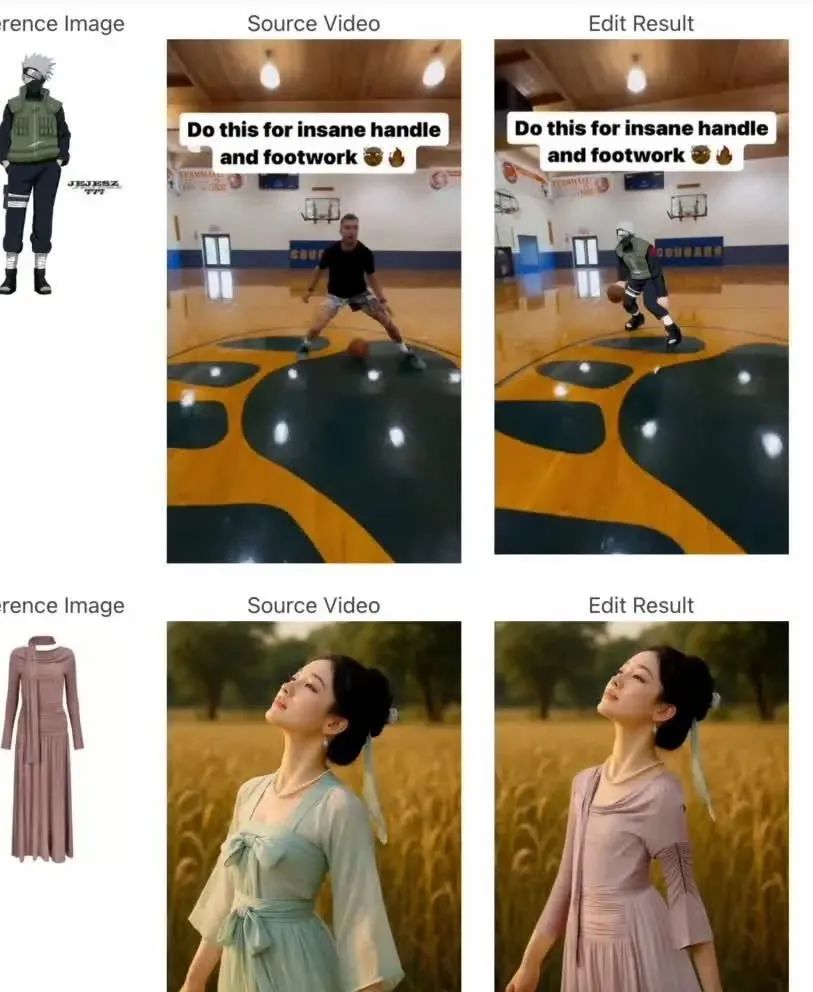

- 一段现有视频: 甚至可以把它当成一个高级编辑器,比如把视频里的某个物体换成你指定的图片里的东西!

这感觉就像是,你把视频创作的“灵魂”(主体)和“剧本”(文字、音频、场景)一股脑儿丢给它,然后它就能给你一个“形神兼备”的成品。

它究竟是怎么做到的?揭秘背后的“黑科技”

根据腾讯放出的论文《HunyuanCustom: A Multimodal-Driven Architecture for Customized Video Generation》和技术解读,这里面确实藏着一些巧妙的设计:

- 身份锁定增强模块 (Image ID enhancement module): 这是核心!他们不是简单地把图片信息塞进去,而是用了一种更聪明的方式,通过时序拼接 (temporal concatenation) 等技术,把这个“身份特征”像DNA一样,刻进每一帧视频里,并且确保帧与帧之间能稳定传递。这样,不管角色怎么动,怎么换角度,那张脸、那个物体的核心特征都能被“牢牢记住”。

- LLaVA 图文理解模块: 这个模型集成了基于LLaVA的图文融合能力,能更深刻地理解你的“剧本”——把图片里的主角和文字描述的动作、场景精确地关联起来。比如你给了一只熊猫图片,然后说“它在打太极”,模型就能理解并生成一只熊猫真的在打太极,而不是随便扭两下。

- 分门别类的条件注入: 针对不同的输入模态,它有不同的处理通道。

- AudioNet: 专门处理音频,让AI生成的数字人说话时,口型、表情能和声音完美对齐。

- 视频驱动模块: 让你能像玩乐高一样,把指定的主体“贴”到现有视频里,并且融合得相当自然。

数据说话:“王炸”不是随便吹的!

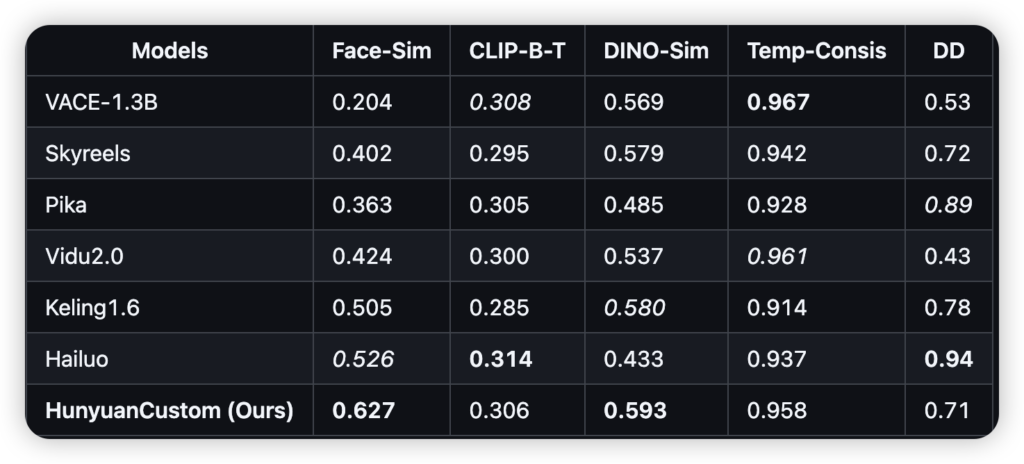

腾讯在技术评测中晒出了几项硬核数据,来证明Hunyuan Custom确实有料:

- 人脸相似度 (Face-Sim): 0.627! 这个数值是衡量生成视频里人脸和输入图片有多像。0.627可不是个小数字,在公开数据里,它直接位列第一,远超不少现有模型。

- DINO 相似度: 0.593! 这个更厉害,它衡量的是语义级别的一致性,比如一个物体是不是那个物体,它的特征有没有保持。Hunyuan Custom同样拿下第一。

- 时序一致性 (Temporal Consistency): 0.958! 这个分数越高,说明视频越流畅、越连贯,画面不会跳帧或者抖动。0.958已经非常接近满分了。

这些数据像是一份成绩单,直观地告诉我们:Hunyuan Custom 在“认人/物”、“动作流畅度”和“内容对齐”上,确实交出了一份非常漂亮的答卷。

应用场景:这波操作能玩出什么花?

有了这样一款能“锁定角色”的多模态视频生成工具,未来的应用场景简直是脑洞大开:

- 数字人: 生成形象稳定、能说会道的虚拟主播、客服、讲师,成本大大降低。

- 虚拟试穿/试用: 用户上传自己的照片,AI就能生成他穿着某件衣服、使用某个产品的视频效果,电商的新利器!

- 个性化广告: 快速生成带有特定人物形象(比如网红、明星或普通用户自己)和产品信息的定制化广告短片。

- 内容创作: 制作有固定角色的短剧、动画演示、教育科普视频,门槛降低。

- 视频编辑新玩法: 想把视频里的某个角色换成你朋友?想让图片里的物品动起来出现在视频里?Hunyuan Custom让这变得可能。

开源啦!快来玩玩!

最让人兴奋的是,腾讯混元这次选择了开源!他们已经在GitHub上开放了Hunyuan Custom的部分代码。

目前,最核心的“单主体视频定制化”的推理代码和模型权重 (checkpoints) 已经可以获取了!这意味着开发者可以下载代码在本地尝试,普通用户也可以通过腾讯混元官网的“模型广场”在线体验单主体生成功能了。

这只是第一步!腾讯团队计划在本月内(5月)陆续开源更多能力,包括:

- 音频驱动的视频定制化

- 视频驱动的视频定制化

- 多主体视频定制化 (想象一下,一个视频里多个角色都不变脸!)

- 甚至还有方便第三方集成的 ComfyUI 插件!

这波操作,不仅展示了腾讯混元的技术自信,更是希望能推动整个AI视频生成社区的发展。

结语:告别“变脸怪”,迎接AI视频创作新时代!

过去,AI视频生成虽然炫酷,但角色“不稳定”就像是个拦路虎,让很多创意难以落地。Hunyuan Custom的出现,尤其是在主体一致性上的突破,以及它强大的多模态控制能力,可以说是搬走了这块大石头。

它不仅降低了高质量AI视频的创作门槛,也为开发者提供了新的探索方向。随着更多功能的开源和社区的共同努力,我们有理由相信,一个主体稳定、内容可控的AI视频创作新时代,真的要来了!

各位好奇宝宝们,别犹豫了,赶紧去混元官网或者GitHub围观吧!看看这个能“记住”角色的AI,到底能变出什么新花样!

快速通道:

- 在线体验(单主体生成): https://hunyuan.tencent.com/modelSquare/home/play?modelId=192

- 项目官网(含介绍): https://hunyuancustom.github.io/

- GitHub 代码库: https://github.com/Tencent/HunyuanCustom

- 技术论文(arXiv): https://arxiv.org/pdf/2505.04512

一起见证AI视频的新篇章吧!

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站

文章评论