说实话,过去几年的AI修图体验,常常让人哭笑不得。

你扔给AI一张照片,说“把背景里的路人去掉”,结果它可能把主角的脸也换了一张,或者背景直接变成了一团难以名状的模糊色块。这就是传统AI的通病:听不懂人话,更不懂画面逻辑。

但在2026年1月26日,腾讯混元团队甩出了一张王炸——混元图像3.0图生图模型(HunyuanImage 3.0-Instruct)。这次更新,可能真的要让那些复杂的修图软件吃灰了。

它不再是瞎蒙,而是学会了“谋定而后动”

这个模型最吓人的地方,不在于它生成的画质有多好(虽然确实很好),而在于引入了一种类似大语言模型的“思维链”机制。

简单来说,当你下达指令时,之前的AI是“听到命令直接动手”,而混元3.0是“先看图,再理解命令,然后在大脑里规划步骤,最后才动手”。

比如你给它一张风景照,说“把画面改成赛博朋克风格,但不要动那棵老树”。混元3.0会先进行感知分析,识别出“整体风格”需要变,但“老树”这个区域必须锁死。它在内部生成了一套详细的执行策略,明确了改哪里、保哪里。

这种“先思考,后执行”的逻辑,直接解决了AI修图最大的痛点:精准度。它能确保你在修改画面一部分时,其他不需要动的地方保持原汁原味,不会出现那种“修了个寂寞”或者“改得面目全非”的尴尬。

800亿参数的“肌肉”与精打细算的架构

在硬核参数上,腾讯这次也是下了血本。

这是一个拥有800亿(80B)总参数量的庞然大物。但作为技术观察者,我更感兴趣的是它的架构——混合专家模型(MoE)。

这意味着什么?意味着虽然它脑容量巨大,但它不会每次干活都把所有脑细胞调动起来。它在运行时只激活约130亿(13B)参数。这就好比一个拥有80个顶级专家的团队,遇到具体问题时,只派最懂行的那13个人出马。既保证了处理复杂任务的能力,又极大地提高了推理效率。

从“P图”进化到“创作”

具体能干什么?如果你是做内容的,这简直是生产力解放。

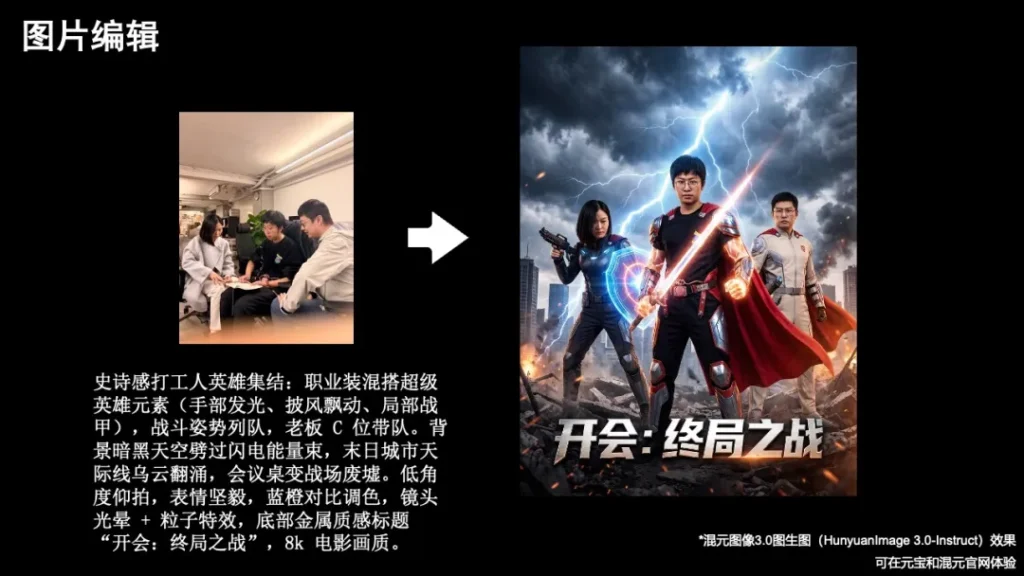

首先是精细化编辑。不管是增删物体、老照片修复、人物换装,还是把一张平平无奇的照片瞬间变成水墨画,也就是一句话的事。甚至连图片里的文字都能改,这在以前往往需要专业设计师花不少时间。

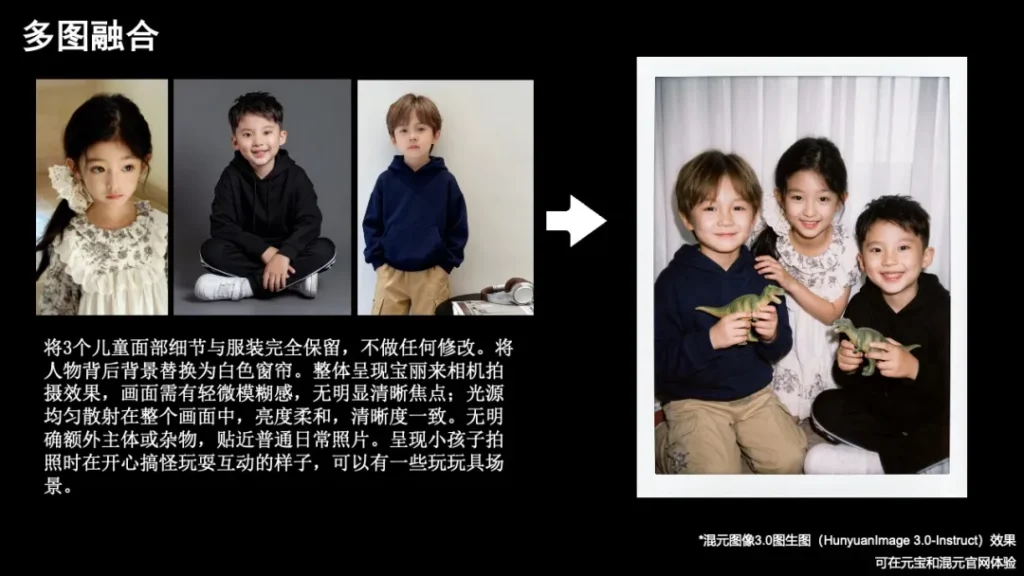

其次是多图融合。这个功能非常惊艳。你可以把几张不同照片扔进去,让它提取其中的人物或元素,然后自然地融合在一张新图里。不是那种生硬的拼贴,而是光影、透视都完全协调的重新生成。想和二次元角色合影?或者把产品图完美融入特定的风景背景?它都能搞定。

背后的技术护城河

为了训练这个“大脑”,腾讯构建了一个覆盖80多种细分任务、千万级别的专用数据集。更关键的是,他们采用了一种自研的MixGRPO算法。

这个算法的作用,就是为了解决“听话”和“保真”之间的矛盾。它通过强化学习,不断纠正模型的行为,确保输出结果既符合你的修改意图,又不会破坏原图的和谐感。这就像是给AI请了一个严格的导师,时刻盯着它的作业,一旦画歪了立刻纠正。

写在最后

目前,这个模型已经在腾讯的AI助手“元宝”全端和混元官网上线了。

如果你受够了在修图软件里为了抠图抠半天,或者为了调一个色调反复拉曲线,不妨去试试这个新家伙。在这个AI技术狂飙突进的时代,工具的进化不仅仅是为了偷懒,更是为了让我们把有限的精力,从繁琐的操作中解放出来,投入到更有价值的创意构思中去。

毕竟,让AI学会思考,是为了让我们更好地创造。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站