在很长一段时间里,AI圈流行着一种近乎迷信的观点:大力出奇迹。参数量越大,模型越强,这似乎成了不可撼动的铁律。然而,2026年开年,阶跃星辰(StepFun)甩出的一张“王炸”,狠狠地给这个观点祛了魅。

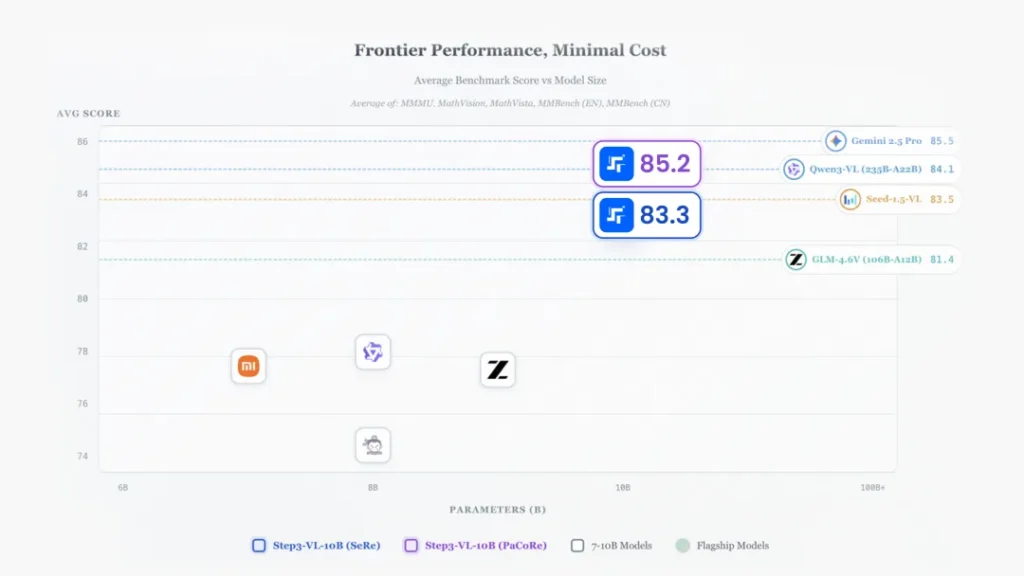

他们刚刚开源的 Step3-VL-10B,是一个仅有100亿参数的多模态模型。在动辄千亿甚至万亿参数的巨兽面前,它本该是个不起眼的“小弟”。但实际测评结果却令人瞠目结舌:这个“小钢炮”不仅在多项基准测试中碾压了参数规模是其10倍甚至20倍的对手(如Qwen3-VL-235B、GLM-4.6V),甚至在某些高难度科目上,直接叫板GPT-4o和Gemini 2.5 Pro等顶流闭源模型。

这不仅仅是一次性能的提升,更像是一场关于“计算效率”的革命。

当小模型开始“思考”:数据不会撒谎

让我们先抛开晦涩的技术名词,直接看战绩。

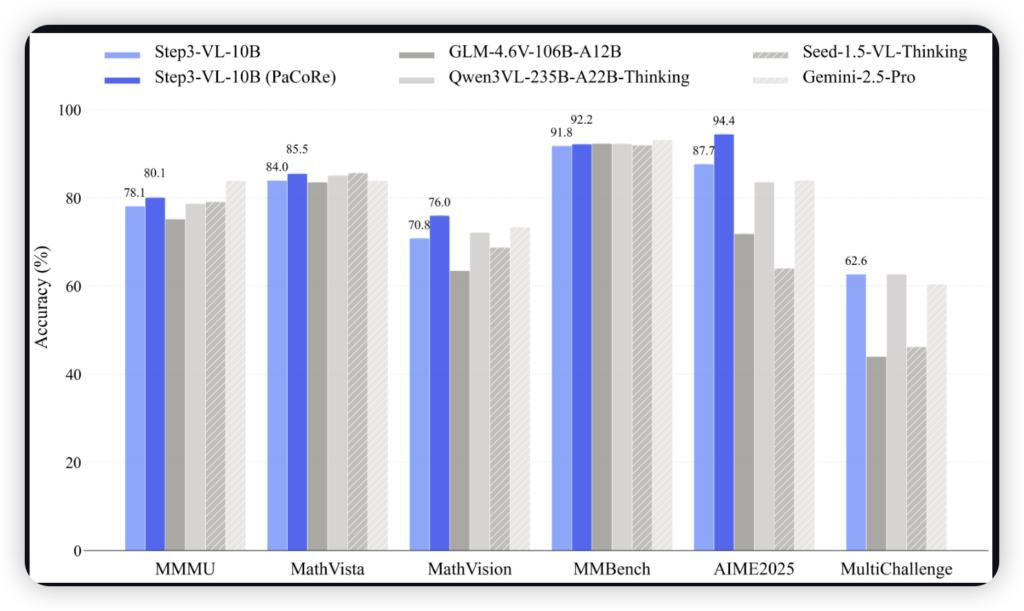

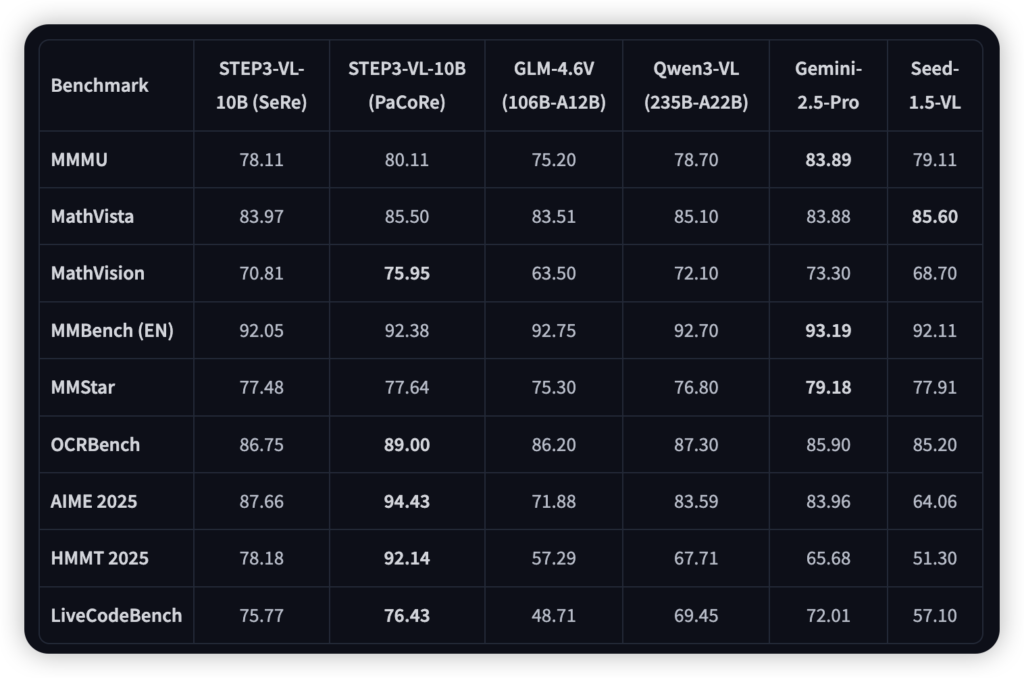

在代表数学推理巅峰的 AIME 2025 竞赛题测试中,Step3-VL-10B 拿下了 94.43% 的惊人高分。作为对比,名声在外的 GPT-4o 在同类测试中的表现约为 88%。要知道,这是一个能够在消费级显卡甚至高端终端设备上运行的小模型。

在综合多模态理解(MMMU)上,它得分 80.11%,超越了谷歌的 Gemini 2.5 Pro(70-72%区间)。在代码能力(LiveCodeBench)上,它以 76.43% 的成绩,把拥有1060亿参数的 GLM-4.6V(48.71%)远远甩在身后。

这些数据不仅反直觉,甚至有点“不讲武德”。它是怎么做到的?

揭秘背后的黑科技:不靠蛮力,靠脑力

Step3-VL-10B 之所以能以小博大,核心在于它不再只是简单地“预测下一个字”,而是学会了像人类一样“深思熟虑”。阶跃星辰在架构上动了三把手术,每一刀都切在要害上。

第一刀:打通任督二脉的全参数训练 大多数多模态模型为了省事,通常会冻结视觉部分,只训练语言部分。这就像是把眼睛和大脑强行拼在一起,中间总隔着一层膜。Step3-VL-10B 极其奢侈地使用了 1.2万亿 token 的高质量数据,对视觉和语言模块进行了全参数、端到端的联合特训。这让它的“眼睛”和“大脑”在底层逻辑上实现了真正的融合,看图不再是猜谜,而是直觉般的理解。

第二刀:地狱级的强化学习特训 这可能是它变强的关键。模型经历了超过 1400 次的强化学习迭代。这不是简单的微调,而是包含“人类反馈(RLHF)”和“结果导向(RLVR)”的双重打磨。就像一个备战奥数的学生,不仅刷题量大(1.2T数据),还有名师一对一纠错(强化学习),专门死磕逻辑漏洞。

第三刀:PaCoRe机制——让思维学会“分身术” 这是Step3-VL-10B最核心的杀手锏:并行协调推理(PaCoRe)。 传统的模型是一条路走到黑,错了就错了。而 PaCoRe 机制允许模型在遇到难题时,瞬间分裂出 16 到 24 个“思维分身”,并行探索不同的解题路径,最后像开会一样聚合所有证据,交叉验证得出最可靠的结论。 这就是为什么它在数学竞赛和复杂OCR识别上能拿到近乎满分的原因。它不是在瞎猜,而是在反复推敲。虽然这会消耗更多的推理算力,但却让一个小模型拥有了深层逻辑推理的“大智慧”。

从云端跌落凡间:重塑终端交互

Step3-VL-10B 的最大意义,或许不在于跑分,而在于它的“体型”。

10B 的参数量意味着它不需要昂贵的H100集群,完全有机会部署在你的高性能PC、甚至未来的旗舰手机上。

想象一下,它基于海量 GUI 数据训练,能精准识别屏幕上的每一个按钮和窗口。这意味着,未来的 AI 助手不再是云端那个只会陪聊的“吉祥物”,而是能直接帮你操作电脑、整理报表、写代码、甚至玩游戏的本地智能体。它能看懂你的屏幕,理解你的意图,并且操作你的软件——所有这一切,都在本地完成,既高效又隐私。

结语

阶跃星辰这次的开源,给整个行业提了个醒:在算力日益昂贵的今天,无脑堆参数的时代可能正在过去。通过精妙的算法设计(如 PaCoRe)和极致的数据训练,小模型完全可以实现越级挑战。

对于开发者和企业来说,Step3-VL-10B 提供了一个绝佳的选择:你既拥有了顶级的多模态能力,又不必背负沉重的算力成本。

目前,该模型的 Base 版和增强推理的 Thinking 版均已在 Hugging Face 和 ModelScope 上架。如果你是对 AI 效率和端侧智能感兴趣的极客,这个模型绝对值得你下载一试。毕竟,见证“大卫击倒歌利亚”的机会,并不常有。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站