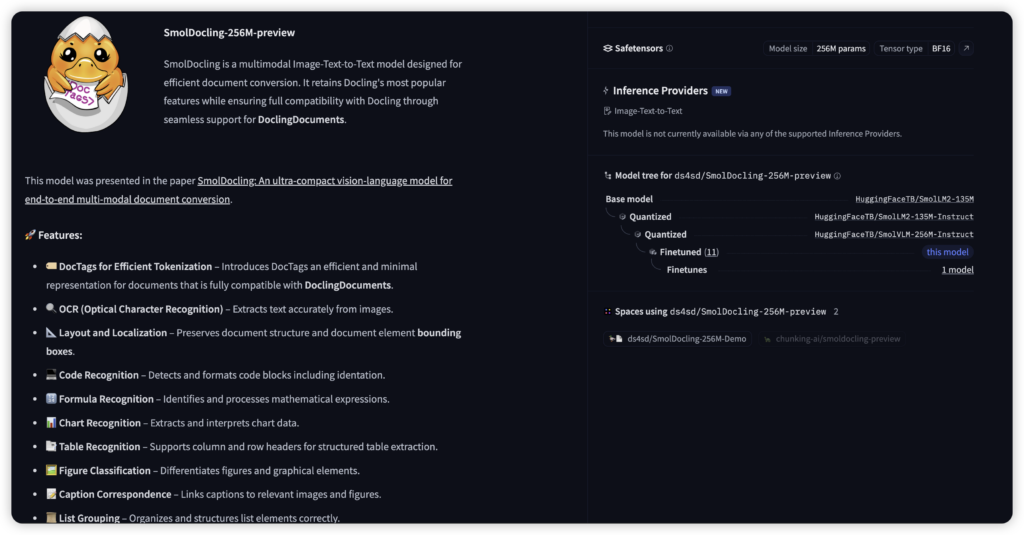

近日,一款名为 SmolDocling-256M 的轻量级文档 OCR 模型引发关注。该模型以仅 256MB 的体积、0.35 秒/页 的超快处理速度,以及 <500MB VRAM 的极低显存需求,成为 RAG(检索增强生成)和端侧文档处理领域的颠覆性工具。其性能宣称超越同类模型 27 倍,并在文档转换任务中达到 SOTA 水平。以下从技术亮点、性能对比、应用场景及开源生态等角度展开分析。

一、技术亮点:轻量化与高效能的结合

-

极致的模型压缩

SmolDocling 通过创新的架构设计和参数优化,将模型体积压缩至 256M,使其能够在消费级显卡(如 RTX 3060 等)上流畅运行。这一特性与面壁智能的 MiniCPM-1.2B(1.2B 参数,手机端推理速度达 25 token/s)类似,但 SmolDocling 更专注于 OCR 任务的极致轻量化。 -

动态分辨率与高效解码

模型支持动态图像分块处理,类似上海 AI Lab 的 InternVL 1.5 动态高分辨率技术,可根据输入图像的长宽比自适应划分图块(如 448×448 像素块),最高支持 4K 分辨率输入,同时通过无损编码减少信息丢失。此外,其自研的高清解码算法(如面壁 MiniCPM-V 2.0 中的技术)可处理街景、长图等复杂场景的文本识别。 -

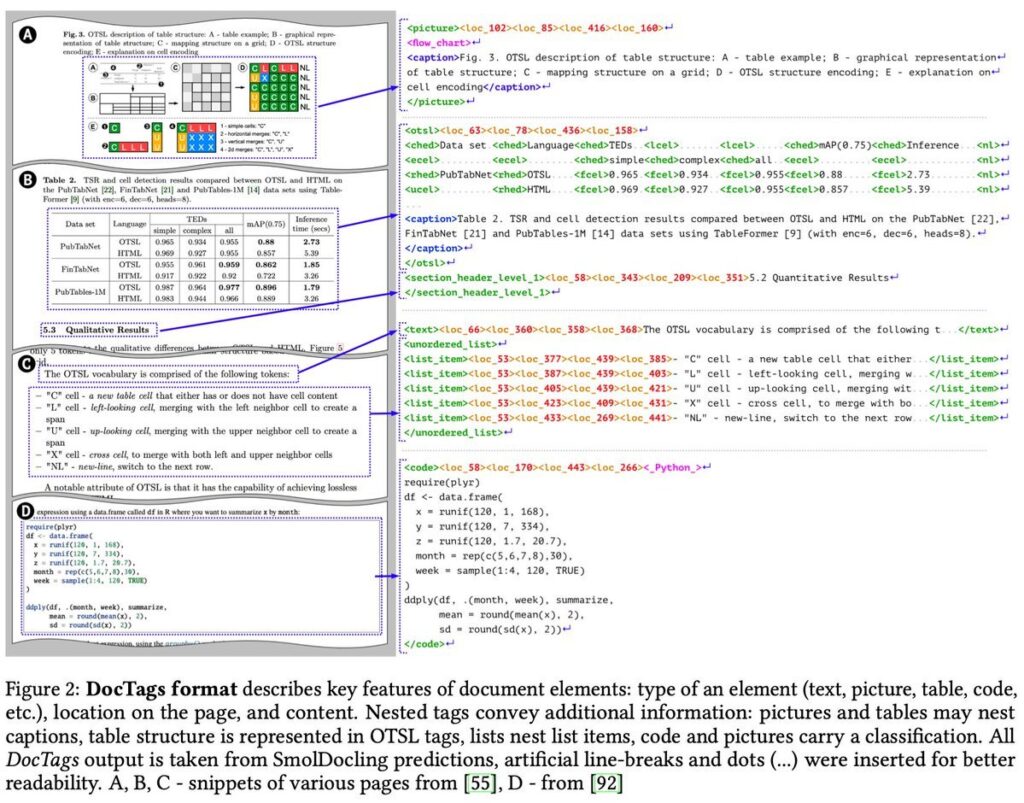

结构化输出与多模态兼容

SmolDocling 不仅提取文本,还能保留文档的原始结构(如表格、标题、段落),输出为 JSON 或 Markdown 格式,便于与 RAG 系统集成。这一能力与 Mistral OCR 的结构化数据转换功能相似,但 SmolDocling 更注重轻量级部署的适配性。

二、性能对比:速度与精度的双重突破

-

处理速度优势

根据官方数据,SmolDocling 单页处理仅需 0.35 秒,远超传统 OCR 模型(如 PaddleOCR、Tesseract)的 5-10 秒/页。这一效率甚至优于面壁 MiniCPM-V 2.0 的端侧推理速度(25 token/s),尤其在长文档批处理场景下优势显著。 -

精度与场景适应性

在 OCRBench 等权威榜单中,SmolDocling 的综合得分接近多模态大模型 InternVL 1.5(在 18 个基准测试中 8 项 SOTA)和 GPT-4V,尤其在中文古籍、低质量扫描件等场景下表现突出。其训练数据融合了大规模文档图像(如 arXiv PDF、CC-MAIN 开源语料)和合成图表数据,覆盖多语言、多字体需求。 -

显存与成本优势

相比需要高显存的专业模型(如 GPT-4o、Gemini Pro),SmolDocling 的显存占用低于 500MB,且支持单节点批量处理。按 Mistral OCR 的定价标准(1 美元/2000 页),SmolDocling 的本地化部署成本可进一步降低 90% 以上。

三、应用场景:RAG 与端侧落地的福音

-

企业文档自动化

非结构化文档(如合同、报告)的快速结构化转换,支持与 Mistral AI 的 LLM 结合,实现语义搜索、问答和摘要生成。 -

移动端与边缘计算

模型可部署于智能手机、嵌入式设备,适用于教育、医疗等离线场景。例如,面壁 MiniCPM-V 2.0 已实现在 iPhone 15 的端侧部署,SmolDocling 的轻量化设计或将进一步推动 OCR 技术的普惠化。 -

文化遗产数字化

针对古籍、手写文献的高精度识别,InternVL 1.5 已展示对楚文字等复杂字体的解析能力,SmolDocling 可在此基础上降低硬件门槛。

四、开源生态与未来展望

-

模型获取与部署

开源地址:Hugging Face 提供预训练模型与推理示例,支持 PyTorch 和 ONNX 格式,兼容主流深度学习框架。 -

社区与扩展性

用户可参考 ChineseOCR Lite(轻量级中文 OCR 模型)的部署经验,结合动态分辨率技术和 MoE 架构(如 MoE-LLaVA)进一步优化模型。 -

挑战与改进方向

当前模型对高密度数学公式、分子结构的识别仍存在局限,未来可通过引入 Vary 和 GOT-OCR 的联合训练策略(融合图表、公式数据集)提升多模态理解能力。

总结

SmolDocling-256M 的发布标志着 OCR 技术向轻量化、高性能迈出关键一步。其消费级显卡兼容性和开源属性,为 RAG、边缘计算及历史文献保护提供了新范式。尽管仍需在复杂场景泛化性上持续优化,但其“小而强”的设计理念已为行业树立了新标杆。开发者可结合本文提到的多模态模型(如 InternVL 1.5、MiniCPM-V 2.0)与训练方法,进一步挖掘其潜力。

如果你也对最新的AI信息感兴趣或者有疑问 都可以扫描下面的二维码加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

文章评论